[dossier] Intelligence artificielle

06 January 2022

Retrouvez ici tous les articles en lien avec l'intelligence artificielle

Contrôle humain, décisions hybrides : quels enjeux ?

Incursion dans la caisse à outils de la sécurité des grands modèles de langage

Panorama et perspectives pour les solutions de détection de contenus artificiels

Elections : quelles influences de l’IA sur notre vote ?

[Dossier IA générative] - ChatGPT : un beau parleur bien entraîné

[Privacy Research Day] L’intelligence artificielle en pratique

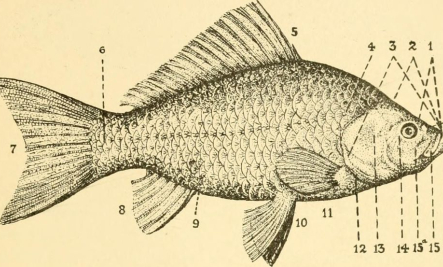

Comprendre le désapprentissage machine : anatomie du poisson rouge

[itw] Camille Girard-Chanudet nous invite au voyage au centre de la justice algorithmique en chantier

BigScience : « Il faut promouvoir l’innovation ouverte et bienveillante pour mettre le respect de la vie privée au cœur de la recherche en IA »

[Données synthétiques] - Et l’Homme créa les données à son image 2/2

[Données synthétiques] - Dis papa, comment on fait les données ? 1/2

[Algaudit] 3 - Evaluer une solution d’audit algorithmique

[Algaudit] 1 - Choisir une solution d’audit algorithmique

[Algaudit] 2 - Expérimenter une solution d’audit algorithmique

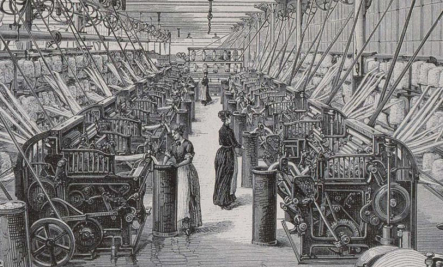

Chacun chez soi et les données seront bien gardées : l’apprentissage fédéré

L'utilisation de l’IA dans la gestion de la crise sanitaire

Nicolas Papernot : « Il faut capturer de façon globale les enjeux de performance ET de sécurité ET de vie privée ET d’équité ! »

Aurélien Bellet et Marc Tommasi : l’apprentissage fédéré, un « nouveau paradigme pour l’apprentissage machine »

Angèle Christin : « Les méthodes ethnographiques nuancent l’idée d’une justice prédictive et entièrement automatisée »

Clément Henin et Daniel Le Métayer : « Fournir des explications du fonctionnement des algorithmes compréhensibles par des profanes »

Philippe Besse : « Les décisions algorithmiques ne sont pas plus objectives que les décisions humaines »

La CNIL norvégienne s'interroge aussi sur les liens entre IA et vie privée

Voitures autonomes : les erreurs des intelligences artificielles tueront-elles le tuning ?

Sans données, le futur de l’IA restera artificiel

Et si on hackait l'intelligence artificielle ?

Chatbots: des humains comme les autres ?