Comprendre le désapprentissage machine : anatomie du poisson rouge

Rédigé par Alexis Léautier

-

26 mai 2023Alors que les risques que font porter les modèles d’IA sur les données d’entraînement font encore l’objet d’études, et qu’il semble difficile de déterminer si les paramètres d’un modèle constituent des données à caractère personnel, certains chercheurs prennent le pari d’un renforcement de la législation sur ces objets et développent des solutions innovantes pour répondre à des obligations encore à venir.

Le désapprentissage machine fait partie de ces solutions. Cette technique pouvant être mise en œuvre par une diversité de protocoles fait l’objet d’un nombre important de publications qui ont attiré l’attention du LINC.

A l’aune du succès obtenu par des équipes académiques dans leur tentative de déduire des informations à propos de personnes présentes dans une base de données ayant servi à entrainer un modèle d’IA, une problématique nouvelle, le machine unlearning, littéralement « désapprentissage machine », est apparue. Comme décrit dans l’article Petite taxonomie des attaques des systèmes d’IA, ces équipes académiques ont réussi à prouver d’une part qu’il était possible de déduire que les données d’une personne ont été utilisées pour l’entraînement d’un algorithme (comme Homer et al., 2008 qui ont démontré qu’un génome particulier était présent dans une base), mais également qu’il était possible de reconstruire certaines données de l’ensemble d’entraînement (à l’instar de Fredrikson et al., 2015 qui sont parvenus à reconstituer une version dégradée du visage d’une personne depuis un algorithme entraîné sur une base beaucoup plus large).

En réponse à ces nouveaux risques, le désapprentissage machine permettrait de modifier l’algorithme entraîné de telle sorte à lui faire « oublier » les informations apprises concernant les individus présents dans la base d’entraînement. Toutefois, cette nouvelle problématique doit tenir compte de certains enjeux comme ceux de la performance de l’algorithme ou des coûts relatifs à sa mise en œuvre. Plus largement, nous verrons que l’efficacité de cette approche reste questionnable en raison de la difficulté à prouver son efficacité et des risques supplémentaires qu’elle fait peser sur la protection des données.

Comment désapprendre ?

En 2015, Cao et al. soulèvent le risque sur la vie privée que font peser les modèles d’IA et propose une approche novatrice pour y répondre, le terme de désapprentissage machine est né. Suite à cette première, de nombreuses études ont suivi, proposant une grande diversité de réponses à la question de comment désapprendre, alors que la définition du désapprentissage lui-même manque encore de clarté.

Désapprentissage : une définition floue

Par désapprentissage, sont visées les techniques permettant à un algorithme d’oublier certaines informations. Si les algorithmes concernés sont relativement bien identifiés – il s’agit principalement des algorithmes ayant recours à l’apprentissage machine, et dont la complexité rend la tâche de désapprentissage trop difficile pour qu’elle soit effectuée manuellement – les informations concernées, elles, sont encore mal définies.

En effet, à l’origine de cette initiative, l’objectif identifié dans Cao et al. était de prémunir un système contre un empoisonnement d’une partie des données d’entraînement. La réponse apportée visait ainsi à faire oublier à l’algorithme la contribution d’un sous-ensemble des données d’entraînement. Cet objectif a par la suite été complété par l’idée introduite par Gupta et al., que lorsque les données empoisonnées sont mal identifiées, on peut souhaiter en oublier la contribution petit à petit, c’est la technique de désapprentissage par flux.

Après cette première initiative, d’autres ont suivi, dont les objectifs varient. En soulevant que l’exercice des droits d’opposition et du droit à l’effacement des données, introduits par le RGPD, pourrait nécessiter le réentraînement d’un modèle, certains chercheurs ont introduit l’idée qu’il pouvait suffire de faire oublier au système la contribution de quelques points bien identifiés correspondant à une personne particulière.

Enfin, d’autres approches ont été proposées afin de répondre à des situations bien spécifiques, tel que recensé par Nguyen et al., 2022 :

- Le désapprentissage de certaines caractéristiques, tel que l’âge ou un diagnostic médical comme proposé par Warnecke et al., lorsque le modèle a été entraîné sur ces données mais que l’on souhaite que le modèle les oublie afin d’éviter de révéler ces informations à propos des personnes concernées.

- Le désapprentissage de certaines classes pour les algorithmes de classification, illustré par les travaux de Tarun et al. sur des algorithmes de classification d’images et notamment de reconnaissance faciale, où chaque classe correspond à une personne : lorsqu’une personne doit être retirée du système, désapprendre son visage peut-être une solution.

- Le désapprentissage de certaines tâches, dans des situations spécifiques tel que celle décrite par Liu et al. d’un robot médical ayant appris à effectuer certains soins propres à un patient, et qu’il devrait en partie désapprendre lors de la guérison du patient.

La grande diversité de ces objectifs montre l’ampleur de la tâche que constitue le désapprentissage, et donne un aperçu de l’éventail des solutions proposées dans la littérature.

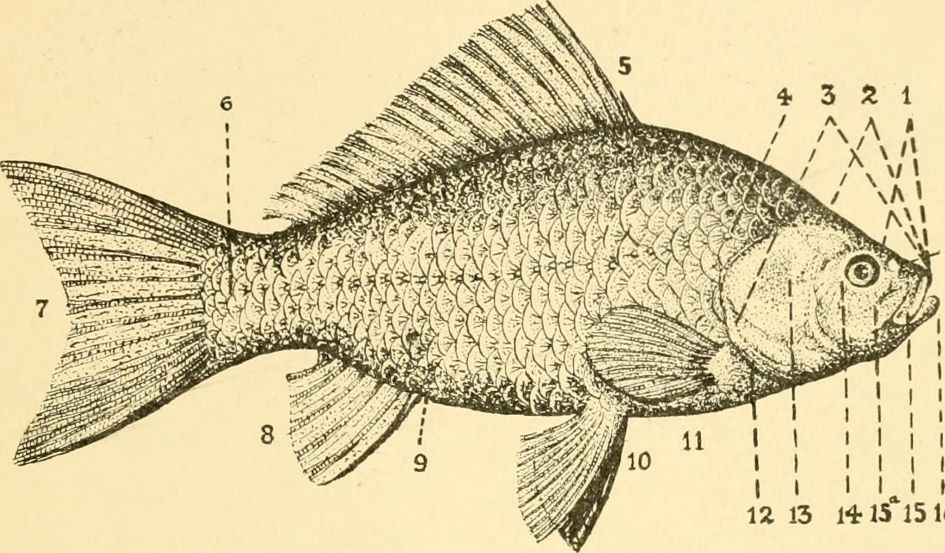

Figure 1 : Représentation des pixels ayant été décisifs pour reconnaître une chaise, une table, et une lampe dans une image. Dans un réseau de neurones, les neurones activés par ces pixels sont ceux à considérer pour désapprendre la reconnaissance de ces objets. (source)

L’approche « naïve » : le désapprentissage exact

En formulant le problème selon l’énoncé suivant : « comment obtenir un modèle d’IA réalisant la même tâche que le système existant mais à l’entraînement duquel certaines données n’auraient pas contribué ? », la solution triviale semble être de ré-entraîner le modèle d’IA sur un ensemble de données privé des données concernées.

Si cette approche offre une réponse indéniable au problème – et ainsi, un exemple de l’objectif à atteindre pouvant être utilisé pour comparer d’autres approches – ses coûts temporel, logistique et financier représentent un inconvénient majeur. En effet, l’entraînement de modèles d’apprentissage profond en particulier nécessite de nombreuses itérations d’apprentissage requérant entre quelques minutes et quelques heures pour les modèles les plus légers, mais pouvant atteindre un nombre d’heures de calcul faramineux, comme dans le cas du modèle de langage de grande taille BLOOM, résultat du projet BigScience, dont l’équipe s’était entretenue avec le LINC dans une publication de novembre 2022, pour lequel 5 millions d’heures de calcul ont été nécessaires comme précisé dans cet article du Monde. Ces nombreuses heures de calcul impliquent bien sûr un coût financier, dû notamment au fonctionnement des centres de données gourmands en énergie. Elles peuvent avoir un impact sur les activités d’une entreprise ou d’une administration en raison des retards causés par l’apprentissage lui-même, mais également en raison de l’attente nécessaire pour accéder aux serveurs de calcul. Dans le cas de BigScience, le supercalculateur Jean-Zay utilisé n’est mis à disposition que pour certains projets triés sur le volet. Enfin, le coût écologique de ces calculs n’est pas à négliger : bien que l’énergie d’approvisionnement du supercalculateur français soit principalement issue de la production nucléaire, l’impact environnemental de l’entraînement est comparable à celui d’un vol transatlantique.

Pour toutes ces raisons, de nouvelles approches ont vu le jour dans la recherche académique.

Le désapprentissage approximatif

Afin de faire désapprendre une information à un modèle entraîné, plusieurs approches peuvent être distinguées : par modification des données, du protocole d’apprentissage, ou encore du modèle lui-même. Ces approches regroupent chacune une grande variété de méthodes, chacune possédant ses avantages et inconvénients. Plutôt qu’une cartographie fastidieuse de ces critères, cette section donne à voir une sélection de quelques méthodes proposées dans la littérature scientifique afin d’en dessiner les traits principaux.

Par modification des données d’entraînement

Plutôt que de retirer les données ayant à être oubliées de l’ensemble, certaines approches cherchent à oublier (ou à prévenir) la contribution des données en jouant sur leur rôle lors de l’apprentissage.

Un premier exemple est celui de Huang et al., 2021, qui introduit une perturbation (un « bruit ») savamment conçue et imperceptible pour un observateur, afin de rendre inexploitables les données dont on veut empêcher toute contribution lors de l’entraînement de réseaux de neurones. Le bruit est choisi de telle sorte à minimiser l’erreur de prédiction lors de l’apprentissage, ce qui conduit le modèle à ne rien apprendre des données en question : leur contribution est donc absente du modèle entraîné. Un projet similaire est celui de Shan et al., 2023, qui introduit une perturbation imperceptible sur des images d’œuvres d’art afin de rendre impossible l’apprentissage du style de l’artiste. Grâce à cette solution appelée Glaze, les auteurs entendent rendre plus difficile la reproduction du style d’un artiste par une IA générative, ce qui peut constituer une violation du droit d’auteur.

Un second exemple fournit par Tarun et al., 2022, utilise le raisonnement inverse : il cherche à maximiser l’erreur de prédiction sur les données à oublier lors d’une phase de spécialisation, ou fine-tuning[1], du modèle. Lors de cette phase, le modèle ayant appris les caractéristiques des données à oublier en vient à désapprendre ces caractéristiques car elles lui apparaissent comme du bruit inexploitable en raison de l’erreur introduite artificiellement. Toutefois, cette approche fonctionne davantage pour désapprendre une classe que pour une donnée en particulier car le modèle en vient à oublier une caractéristique statistique qu’il avait apprise.

Ces deux approches possèdent l’inconvénient de ne pas fournir de garanties formelles sur l’effectivité du désapprentissage, de plus, elles nécessitent de réaliser un traitement additionnel des données à oublier lors du désapprentissage comme détaillé dans la partie 3.

Par modification du protocole d’apprentissage

Certains procédés de désapprentissage reposent sur une modification apportée au procédé d’apprentissage venant faciliter le désapprentissage le moment venu. Cette approche par anticipation repose généralement sur l’utilisation de « points de sauvegarde » auxquels se référer pour éviter d’entraîner complètement le modèle à nouveau.

L’approche proposée par Bourtoule et al., 2021, par exemple, repose sur le partitionnement des données d’entraînement en plusieurs sous-ensembles sur lesquels le modèle est entraîné successivement. Des informations sont sauvegardées entre chacune de ces étapes afin de pouvoir reprendre l’entraînement uniquement sur les sous-ensembles de données dans lesquels les données à oublier figuraient. Le modèle est ainsi réentraîné sur ces sous-ensembles après avoir retiré les données en question.

Cao et al., 2015, proposent, quant à eux, d’ajouter une étape lors de l’apprentissage pour ne plus entraîner le modèle sur les données brutes, mais plutôt sur des agrégats statistiques. Dans ce cas, une première étape consiste ainsi à agréger les données sources par des calculs statistiques, puis d’entraîner l’algorithme sur les résultats de ces calculs. Puisqu’ils sont en faible nombre, l’entraînement du modèle sur les agrégats est suffisamment rapide pour autoriser un apprentissage complet. On procède ainsi à un ré-apprentissage complet sur des agrégats calculés à partir de l’ensemble de données privé des données à oublier. Cette approche présente l’avantage de garantir le désapprentissage, toutefois, elle n’est pas généralisable aux modèles les plus complexes (comme les réseaux de neurones) en raison du nombre très important d’agrégats statistiques nécessaires pour ceux-ci.

Par modification du modèle entraîné

Plutôt que de procéder à un réentraînement du modèle, certaines publications se concentrent sur l’information apprise par le modèle à propos des données à oublier. Plusieurs protocoles sont alors proposés pour effacer cette information.

Dans Chundawat et al., 2022, le modèle entraîné sur l’ensemble complet de données est utilisé comme « instructeur compétent » pour un autre modèle « étudiant » afin de lui transmettre les informations que l’on souhaite conserver, alors qu’un autre modèle, appelé « instructeur incompétent » assurera de la mauvaise performance de l’étudiant sur les données à oublier. Le protocole consiste ainsi à reproduire les prédictions de l’instructeur compétent sur toutes les données, exceptées celles à oublier sur lesquelles l’instructeur incompétent prendra la main.

Dans Golatkar et al., 2020, les paramètres du modèle entraîné sur l’ensemble de données complet sont modifiés de manière ciblée afin de réduire l’influence des données à oublier sur le modèle. La modification apportée est un filtre de bruit choisi de telle sorte à cibler les paramètres les plus influencés par les données à oublier, en impactant aussi peu que possible la performance globale du système. L’avantage de cette approche est qu’elle permet non seulement de rendre le modèle incompétent sur les données à oublier, mais également de prévenir tout risque d’attaque par inférence, puisque les informations apprises par le modèle sur les données à oublier auront été altérées lors du procédé.

Le désapprentissage : une alternative potentielle à la suppression du modèle ?

En 2021, la FTC a ordonnée la suppression de jeux de données collectés de manières illicites ainsi que la destruction de tous les modèles entrainés sur ces données. Si le désapprentissage venait à se développer, il serait possible de remplacer la suppression complète du modèle par le désapprentissage des données collectées de façon illicite. Cette décision, qui possède des conséquences financières importante pour l’entreprise visée pose question sur sa proportionnalité si elle était appliquée au cas général. En effet, on peut s’interroger sur :

- Les causes d’illicéité qui justifieraient une suppression du modèle : un manquement à l’information des personnes, l’absence de la possibilité d’exercer ses droits, la collecte non justifiée de données sensibles par exemple entraîneraient-elles toutes l’obligation de supprimer le modèle ?

- Le rôle de l’entreprise ayant entraîné un modèle dans la collecte des données : faut-il exiger une suppression du modèle que l’entreprise ait réutilisé un jeu de données publiquement accessible sur un site tel que Kaggle, ou qu’elle ait collectée elle-même les données par scraping sur des sites protégés ?

Le désapprentissage machine pourrait ainsi offrir une alternative au régulateur pour faire valoir les droits des personnes concernées lorsque le manquement ne justifie pas une suppression pure et simple du modèle.

Obstacles et garanties

En théorie, le désapprentissage machine semble être une mesure toute indiquée pour donner suite à une demande d’exercice de droit à l’effacement ou d’opposition au traitement s’il était considéré que le modèle devait être adapté suite à cette demande. Puisqu’il permettrait de s’assurer qu’un modèle ne permet pas d’inférer d’information à propos d’une personne, il pourrait même être recommandé comme bonne pratique de sécurité pour éviter la fuite d’informations personnelles à partir des modèles. Toutefois, comme le décrivent les deux parties qui suivent, sa mise en œuvre présente certaines difficultés, pour des garanties encore incertaines.

Des difficultés techniques

Par nature, l’objectif à atteindre par la tâche de désapprentissage peut sembler vain. En effet, désapprendre les informations relatives à certaines données sans impacter la performance globale du système apparaît paradoxal puisque d’une part, ce sont les informations tirées des données qui décrivent le modèle entraîné, et, d’autre part, on peut s’interroger sur l’intérêt d’avoir ré-entraîné un modèle produisant les mêmes sorties que le modèle initial, ce qui est présenté comme l’objectif théorique du désapprentissage. Ainsi, devant ce paradoxe de fond, le choix des métriques à utiliser pour juger de l’efficacité du désapprentissage pose question. Plusieurs sont proposées dans la littérature :

- la distance euclidienne entre les poids des deux modèles un à un : cette métrique simple n’est pas toujours fiable en raison de l’aléatoire pouvant exister lors de l’apprentissage d’un modèle [2] ;

- le Zero Retrain Forgetting (ZRF) score : la sortie du modèle ré-entraîné sur les données à oublier est comparée à celle d’un modèle initialisé de manière aléatoire et donc n’ayant aucune connaissance des données à oublier. Ce score ne peut être utilisé que pour oublier des classes entières ;

- le taux de succès d’attaques visant à extraire des informations relatives aux données à oublier : afin de mesurer cette quantité, il est généralement nécessaire de définir un protocole d’attaque (par inférence d’appartenance ou par inversion de modèle généralement). Cependant, ce protocole ne sera généralement pas capable de représenter l’exhaustivité des risques existants en pratique (aujourd’hui ou et encore moins à l’avenir) ;

- l’Anamnesis index (AIN) : cet indicateur mesure à quel point un modèle a oublié grâce au nombre d’itérations d’apprentissage nécessaires pour apprendre à nouveau les caractéristiques oubliées. En comparant ce nombre d’itérations à celui nécessaire pour ré-entraîner un modèle entraîné sur un ensemble privé des données à oublier, l’AIN indique d’une part lorsque le modèle n’aurait pas assez oublié, mais également lorsqu’il a trop oublié, ce qui signifie qu’il a également oublié des caractéristiques qui n’étaient pas propres aux données oubliées, ce qui pourrait impacter la performance.

Cet échantillon de métriques permet d’identifier certaines des difficultés majeures de la tâche.

Premièrement, la nature stochastique, c’est-à-dire probabiliste, du procédé d’apprentissage tant dans la répartition des données dans les itérations d’apprentissage[3] que de par les imprécisions de calcul menant à des résultats différents pour un même apprentissage.

Deuxièmement, la nécessité d’un modèle de comparaison : ce modèle est requis au moins dans une première phase expérimentale pour évaluer l’efficacité de la tâche de désapprentissage. Ce modèle, quasiment identique au modèle initial étant généralement entraîné de zéro sur l’ensemble privé des données à oublier, le désapprentissage perd alors tout intérêt puisqu’il est nécessaire de réaliser un entraînement quasi complet. La comparaison n’étant qu’une vérification, cette étape pourrait être négligée, mais une preuve de la capacité de généralisation de la technique de désapprentissage devient alors nécessaire.

Troisièmement, l’opacité de la phase d’apprentissage, et ainsi la difficulté de tracer l’influence des données sur les paramètres du modèle est un obstacle majeur au développement de ces techniques. Cette difficulté, également rencontrée dans la recherche d’explicabilité des modèles d’IA, trouve toutefois certaines solutions dans des publications récentes, comme Koh et al., 2020, qui parvient à identifier le rôle des données d’entraînement sur les prédictions d’un modèle en boîte noire grâce à des « fonctions d’influence ».

Enfin, la problématique du désapprentissage machine est issue du nouveau risque que font peser les attaques par inversion du modèle ou par inférence sur les données d’entraînement. Ce risque, démontré notamment par Fredrikson et al., 2015 sur un modèle de reconnaissance faciale à partir duquel il est possible de reconstituer un visage utilisé dans l’ensemble d’entraînement, est relativement récent : de nouvelles attaques pourraient émerger et remettre en cause l’évaluation du désapprentissage à partir de tentatives d’attaque. Les modèles désappris aujourd’hui pourraient ainsi révéler demain des informations à propos de données qu’ils étaient censés oublier.

Les difficultés de mise en œuvre du désapprentissage apparaissent ainsi conséquentes, alors que les garanties apportées restent peu satisfaisantes, comme détaillé ci-dessous.

Pour quelles garanties apportées ?

Le recensement effectué par Nguyen et al., 2022, fait mention de plusieurs protocoles de désapprentissage machine apportant des garanties formelles, c’est-à-dire vérifiables avec certitude. Toutefois, ces garanties ne peuvent être apportées que dans certains cas particuliers (notamment pour les modèles linéaires ou les modèles bayésiens, parfois seulement sur une classe dans le cas de la classification et non sur les données). Par ailleurs, ces garanties reposent parfois sur la confidentialité différentielle, qui est connue pour avoir un impact important sur l’utilité, tout en offrant des garanties dont la signification pratique est encore confuse[4]. Seules les approches reposant sur un réentraînement partiel du modèle, avec la garantie que les données à oublier n’auront pas été utilisées, semblent fournir des garanties formelles robustes et transparentes. Toutefois, ces techniques ont un coût puisque le modèle doit être ré-entraîné en partie (ou parfois totalement en cas de malchance), et qu’il implique généralement le stockage de résultats intermédiaires ou la conservation prolongée des données d’entraînement.

Par ailleurs, l’impact du désapprentissage sur la performance du modèle ne semble pas encore maîtrisé. Alors qu’il semble admis que le désapprentissage implique une perte de performance du modèle, Nguyen et al., 2020 liste les solutions apportées au cas particulier du « désapprentissage catastrophique », c’est-à-dire une perte significative de performance du modèle le rendant inutilisable, et semble parvenir à la conclusion qu’une solution généralisable reste à découvrir. Cette perte de performance sur laquelle aucune certitude n’existe, pourrait avoir des conséquences désastreuses dans le cas où l’IA aurait des conséquences importantes pour les personnes.

De plus, les possibilités s’offrant à un responsable de traitement malhonnête qui souhaiterait ne pas réaliser le désapprentissage du modèle suite à une demande d’opposition (pour ne pas risquer de perdre en performance par exemple) sont nombreuses. Tout d’abord, Shumailov et al., 2021, montrait que les performances d’un algorithme pouvaient être modifiées de manière ciblée en changeant l’ordre des données d’entraînement. Des portes dérobées pouvaient ainsi être introduites, et il n’est pas inenvisageable que les données puissent être réarrangées pour ré-entraîner le modèle de telle sorte à dissimuler l’influence des données à oublier. Par ailleurs, un responsable de traitement pourrait certainement créer des données fictives très similaires aux données à oublier et laisser penser que les données à oublier ont été supprimées et que leur influence apparente sur le modèle est due aux données similaires.

En pratique, on peut s’interroger sur l’acceptabilité pour les personnes exerçant leurs droits d’une simple déclaration du responsable de traitement ayant eu recours au désapprentissage. En effet, une garantie formelle sur un procédé, entraîne une garantie ad hoc, mais celle-ci n’est pas explicite et la personne cherchant à exercer ses droits pourrait manquer d’une preuve relative à son cas particulier.

Une mesure technique protectrice de la vie privée ?

Le désapprentissage machine semble encore une mesure de protection absente du viseur des homologues européennes de la CNIL, certainement en raison du manque de maturité de la technique. Pour sa part, la CNIL identifie d’ores et déjà certains des obstacles qu’il s’agira de franchir afin de pouvoir promouvoir cette pratique.

Sur les principes généraux

Nombre des techniques observées reposent sur le stockage de résultats intermédiaires permettant de revenir à un certain stade de l’apprentissage ou de retrouver l’influence d’une certaine donnée sur le modèle entraîné. Ces résultats intermédiaires peuvent prendre différentes formes : valeurs du gradient, sous-ensembles de données, fonctions d’influence, etc. Toutefois, dans tous ces cas, elles comportent des informations relatives aux données à oublier qui n’auraient pas lieu d’exister en l’absence de la démarche de désapprentissage. En l’absence d’une étude plus approfondie sur les informations contenues dans ces résultats intermédiaires, on peut ainsi s’interroger sur la compatibilité de ces approches avec le principe de minimisation.

Par ailleurs, l’absence de preuve formelle pour les désapprentissages dans plusieurs situations peut constituer un obstacle pour considérer ces opérations comme permettent l’exercice des droits.

Sur la licéité du désapprentissage

Bien que certains des protocoles existants aient été développés selon l’idée que le traitement des données à oublier doit être le plus réduit possible pour mettre en œuvre le désapprentissage, d’autres reposent sur un traitement conséquent de ces données. Dans le cas d’une demande d’effacement ou d’exercice du droit d’opposition, ce traitement n’est pas interdit, bien qu’il semble logique de le minimiser. Toutefois, si le désapprentissage a lieu en exécution d’une demande de rectification notamment, le droit à la limitation pourrait s’appliquer. La possibilité pour le responsable de traitement de traiter les données pour désapprendre le modèle pourrait alors être remise en question. Cette situation pourrait ainsi obliger le responsable de traitement à entièrement ré-entraîner le modèle sur un ensemble privé des données à oublier.

D’une manière générale, si la technique de désapprentissage semble une voie intéressante pour le droit à l’effacement (ou d’opposition) dans certains cas, son application pour le droit à la rectification ou à la limitation semblent encore plus complexes.

Sur la responsabilité

Lorsque le modèle d’IA entraîné a été partagé à des tiers (cas fréquent dans le cas d’un dispositif commercial « sur étagère ») et qu’une demande d’effacement a été exercée auprès du fournisseur du modèle, l’article 17.2 du RGPD prévoit dans certaines conditions que le fournisseur informe les responsables de traitement qui « traitent ces données à caractère personnel » de cette demande, afin que ceux-ci procèdent à effacement de « tout lien vers ces données à caractère personnel, ou de toute copie ou reproduction de celles-ci ». Les conséquences de ce paragraphe pourraient être que les utilisateurs d’un modèle d’IA contenant des données à caractère personnel informés par le fournisseur de solution, aient l’obligation de supprimer les données concernées et leur influence sur le modèle, s’il était possible de retrouver les données d’entrainement à partir de celui-ci. Si le désapprentissage pourrait à terme être une solution adaptée à ce problème, il semblerait plus adapté que le système soit mis à jour par le fournisseur de solution, qui dispose des données d’entraînement et des compétences techniques, plutôt que par le réutilisateur. Certaines dispositions (contractuelles par exemple), pourraient prévoir un schéma de sous-traitance envers le fournisseur de solution afin d’effectuer l’effacement.

Sur les mesures de sécurité applicables

Lorsque le protocole de désapprentissage repose sur le stockage de résultats intermédiaires, ceux-ci pourraient permettre d’inférer des informations à propos des données d’entraînement. Ces résultats devraient ainsi être sécurisées au moyen des techniques usuelles comme le chiffrement des sauvegardes ou la gestion des habilitations.

Si le désapprentissage implique plusieurs acteurs, comme cela peut être le cas dans l’apprentissage fédéré, certaines techniques pourraient permettre de limiter les connaissances de chacun des acteurs durant la phase de désapprentissage. Les motivations ayant conduit une personne à demander à exercer son droit à l’effacement pouvant être assez personnelles, il peut être recommandé dans certains cas de limiter la liste des personnes ayant connaissance de cette demande et des données concernées. Ainsi, l’utilisation de techniques comme le chiffrement homomorphe lors du désapprentissage pourrait être considérée, dans la mesure des performances exigées.

Sur l’audit du désapprentissage

Comme décrit précédemment, le désapprentissage n’offre que rarement des garanties formelles sur ses résultats. Par ailleurs, même en présence de garanties formelles, il pourrait être particulièrement difficile de vérifier la validité de ces preuves. Ainsi, pour auditer un procédé de désapprentissage, comme dans le cas d’un contrôle visant à prouver que le droit d’effacement a bien été mis en exécution, d’autres approches doivent être trouvées. Les tentatives d’attaque afin de réidentifier les personnes à partir du modèle entraîné semblent la piste à privilégier, toutefois, certaines difficultés persistent. En effet, comment s’assurer de l’exhaustivité de ces modèles d’attaques, de leur efficacité (au regard de la nature stochastique de certains de ces procédés notamment), et de la pérennité de leurs résultats ?

En conclusion, le désapprentissage machine semble être une technique prometteuse dans certains cas où l’influence de données devrait être oubliée d’un modèle entraîné, comme en cas d’empoisonnement du modèle, de dérive des données, ou encore, dans certains cas, pour l’exécution d’un droit à l’effacement. Toutefois, le coût et la complexité de ces techniques semblent encore trop significatifs en comparaison avec les garanties qu’elles apportent.

[1] La spécialisation du modèle est une phase d’apprentissage supplémentaire pendant laquelle un modèle pré-entraîné est entraîné à nouveau sur un ensemble restreint de données présentant des caractéristiques très proches de celles que le système d’IA rencontrera en phase de production.

[2] Les très nombreux calculs nécessaires à l’apprentissage d’un modèle profond comme un réseau de neurones entraînent généralement des différences dans le résultat final : les erreurs de calcul quasiment imperceptibles réalisées par les machines modernes conduisent à des erreurs visibles lorsqu’elles s’accumulent.

[3] Lors de l’apprentissage, les données sont réparties selon des sous-ensembles, ou batchs, de manière aléatoire. Chaque batch influençant la suite de l’apprentissage, l’ordre de visite des données possède une importance qu’il est difficile d’estimer a posteriori ou de mesurer durant l’apprentissage.

[4] La confidentialité différentielle repose sur le choix d’un seuil epsilon, ε, dont la valeur théorique manque encore de réalité pratique : il est difficile de savoir exactement le niveau de protection qu’une certaine valeur permettra d’atteindre.