Understand machine unlearning: anatomy of a goldfish

Rédigé par Alexis Léautier

-

26 May 2023While the risks posed by AI models on training data are still being studied, and it seems difficult to determine whether the parameters of a model constitute personal data, some researchers are betting on a tightening of legislation on these objects and are developing innovative solutions to meet obligations that are still to come.

Machine unlearning is one such solution. This technique, which can be implemented by a variety of protocols, is the subject of a large series of publications that have attracted the interest of the LINC.

In the light of the success achieved by academic teams in their attempt to deduce information about people in a database used to train an AI model, a new problem has emerged: unlearning machine. As described in the article Small taxonomy of attacks on AI systems, these academic teams have succeeded in proving on the one hand that it is possible to deduce that a person's data has been used to train an algorithm (like Homer et al., 2008, who demonstrated that a particular genome was present in a database), but also that it is possible to reconstitute certain data from the training set (following the example of Fredrikson et al. 2015 who were able to reconstitute a deteriorated version of a person's face from an algorithm trained on a much larger database).

In response to these new risks, machine unlearning would make it possible to modify the trained algorithm in such a way as to make it 'forget' the information learned about the individuals in the training database. However, this new problem must take account of certain issues, such as the performance of the algorithm and the cost of implementing it. More generally, we will see that the effectiveness of this approach remains questionable due to difficulties of proving its effectiveness and the additional risks it poses for data protection.

How do you unlearn ?

In 2015, Cao et al. raised the privacy risk posed by AI models and proposed an innovative approach to address it – which gave rise to the term machine unlearning. Many studies have followed on from this first, proposing a wide variety of answers to the question of how to unlearn, although the definition of unlearning itself still lacks clarity.

Unlearning: a vague definition

Unlearning refers to techniques that allow an algorithm to forget some of the information it has learned. While the algorithms concerned are relatively well identified - mainly machine learning algorithms whose complexity makes the unlearning task too difficult to be carried out manually - the information concerned is still poorly defined.

Indeed, at the origin of this initiative, the aim identified in Cao et al. was to protect a system against the poisoning of part of the training data. The response was thus to make the algorithm forget the contribution of a subset of the training data. This objective was later supplemented by the idea introduced by Gupta et al. that when the poisoned data is poorly identified, we may wish to forget its contribution little by little, which is the technique of unlearning by flow.

After this initial initiative, others followed, with varying objectives. By pointing out that exercising the right to object and the right to erase data, introduced by the GDPR, could require a model to be retrained, some researchers introduced the idea that it could be enough to make the system forget the contribution of a few well-identified points corresponding to a particular person.

Finally, other approaches have been proposed to respond to very specific situations, as identified by Nguyen et al. 2022 :

- Unlearning some of characteristics, such as age or a medical diagnosis, as proposed by Warnecke et al.when the model has been trained on these data but you want it to forget them in order to avoid revealing this information about the people concerned.

- Unlearning of determined categories for classification algorithms, illustrated by the work of Tarun et al. on image classification algorithms, in particular facial recognition algorithms, where each category corresponds to a person: when a person needs to be removed from the system, unlearning their face could be a solution.

- Unlearning of certain tasks, in specific situations such as that described by Liu et al. of a medical robot that has learnt to carry out certain care tasks specific to a patient, and which it should partly unlearn when the patient recovers.

The wide variety of these aims shows the scale of the task of unlearning, and gives an idea of the range of solutions proposed in the literature.

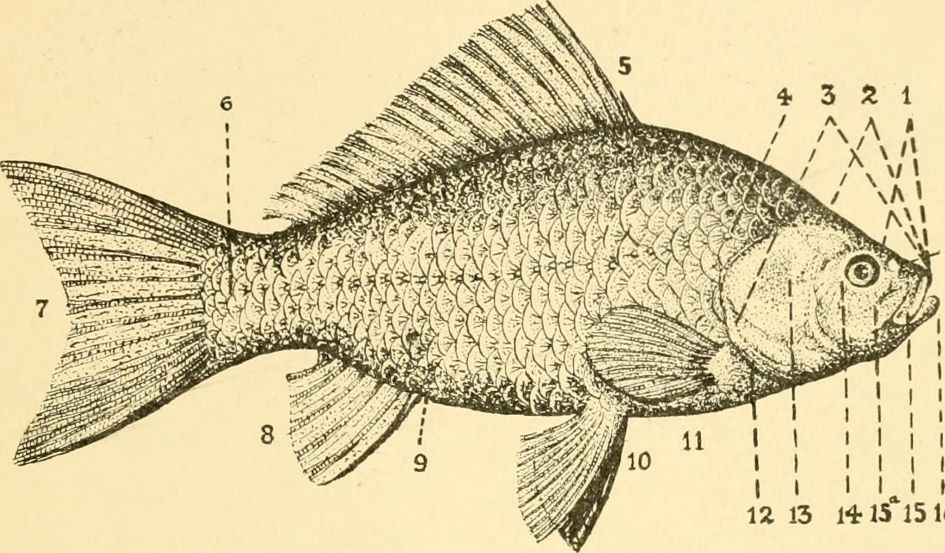

![]()

Figure 1 : Representation of the pixels that were decisive in recognising a chair, a table and a lamp in an image. In a neural network, the neurons activated by these pixels are those to be considered for unlearning the recognition of these objects. (source)

The "naïve" approach: exact unlearning

If we formulate the problem in the following way: "how can we obtain an AI model that performs the same task as the existing system, but to which certain data have not contributed", the trivial solution seems to be to re-train the AI model on a dataset without the data concerned.

While this approach offers an undeniable answer to the problem - and thus, an example of the aim to be reached that can be used to compare other approaches - its time, logistical and financial costs represent a major drawback. Indeed, training deep learning models in particular requires numerous learning iterations requiring between a few minutes and a few hours for the lightest models, but which can reach a staggering number of computing hours, as in the case of the large-scale language model BLOOM, the result of the BigScience project, whose team spoke to the LINC in a November 2022 publication, for which 5 million computing hours were required, as detailed in this article in Le Monde. These many hours of computation naturally involve a financial cost, due particularly to the operation of energy-hungry data centres. They can also have an impact on activities of a company or public authority, because of the delays caused by learning itself, but also because of time needed to access calculation servers. In the case of BigScience, the Jean-Zay supercomputer is only made available for selected projects. Finally, the ecological cost of these calculations should not be overlooked: although the energy used to supply the French supercomputer comes mainly from nuclear production, the environmental impact of the training is comparable to that of a transatlantic flight.

For all these reasons, new approaches have emerged in academic research.

Approximate unlearning

In order to unlearn information from a trained model, several approaches can be distinguished: by modifying the data, the learning protocol, or even the model itself. Each of these approaches encompasses a wide variety of methods, each with its own advantages and disadvantages. Rather than a tedious mapping of these criteria, this section presents a selection of methods proposed in the scientific literature in order to outline their main features.

By modifying training data

Rather than removing data that needs to be forgotten from the set, some approaches seek to forget (or prevent) the contribution of data by playing on their role during learning.

A first example is that of Huang et al. 2021, which introduces a perturbation (a "noise") that is skilfully designed and imperceptible to an observer, in order to render unusable the data whose contribution is to be prevented when training neural networks. The noise is chosen in such a way as to minimise the prediction error during training, which leads the model to learn nothing from the data in question: their contribution is therefore absent from the trained model. A similar project is that of Shan et al, 2023, which introduces an imperceptible perturbation on images of works of art in order to make it impossible to learn the artist's style. With this solution, called Glaze, the authors intend to make it more difficult for generative AI to reproduce an artist's style, which may constitute copyright infringement.

A second example provided by Tarun et al, 2022uses the opposite reasoning: it seeks to maximise the prediction error on the data to be forgotten during a specialisation phase, or fine-tuning[1], of the model. During this phase, the model, having learned the characteristics of the data to be forgotten, comes to unlearn these characteristics because they appear to it as unusable noise due to the artificially introduced error. However, this approach works more for unlearning a class than for a particular piece of data, because the model forgets a statistical characteristic that it had learned.

The disadvantage of these two approaches is that they do not provide formal guarantees of the effectiveness of unlearning, and they also require additional processing of the data to be forgotten during unlearning, as detailed in section 3.

By modifying the learning protocol

Some unlearning processes are based on modifying the learning process to make it easier to unlearn when the time comes. This anticipatory approach is generally based on the use of "backup points" to which reference can be made to avoid completely re-training the model.

The approach proposed by Bourtoule et al.2021, for example, is based on partitioning the training data into several subsets on which the model is trained successively. Information is saved between each of these stages so that training can be resumed only on the subsets of data in which the data to be forgotten appeared. The model is then re-trained on these subsets after the data in question has been removed.

Cao et al., 2015, for their part, propose to add a step during training so that the model is no longer trained on the raw data, but rather on statistical aggregates. In this case, the first step consists of aggregating the source data using statistical calculations, then training the algorithm on the results of these calculations. Since there are only a small number of aggregates, training the model on them is fast enough to allow complete learning. In this way, a complete re-training is carried out on the aggregates calculated from the data set deprived of the data to be forgotten. This approach has the advantage of guaranteeing unlearning, but it cannot be generalised to the most complex models (such as neural networks) due to the very large number of statistical aggregates required.

By modifying the driven model

Rather than re-training the model, some publications focus on the information learned by the model about the data to be forgotten. Several protocols are then proposed for erasing this information.

In Chundawat et al, 2022the model trained on the complete data set is used as a "competent instructor" for another "student" model in order to pass on to it the information that we wish to retain, while another model, called the "incompetent instructor", will ensure that the student performs poorly on the data to be forgotten. The protocol thus consists of reproducing the predictions of the competent instructor on all the data, except those to be forgotten, on which the incompetent instructor will take control.

In Golatkar et al, 2020the parameters of the model trained on the full dataset are modified in a targeted manner to reduce the influence of the forgettable data on the model. The modification made is a noise filter chosen so as to target the parameters most influenced by the data to be forgotten, with as little impact as possible on the overall performance of the system. The advantage of this approach is that it not only renders the model incompetent on the data to be forgotten, but also prevents any risk of attack by inference, since the information learned by the model on the data to be forgotten will have been altered during the process.

Le désapprentissage : une alternative potentielle à la suppression du modèle ?

En 2021, la FTC a ordonnée la suppression de jeux de données collectés de manières illicites ainsi que la destruction de tous les modèles entrainés sur ces données. Si le désapprentissage venait à se développer, il serait possible de remplacer la suppression complète du modèle par le désapprentissage des données collectées de façon illicite. Cette décision, qui possède des conséquences financières importante pour l’entreprise visée pose question sur sa proportionnalité si elle était appliquée au cas général. En effet, on peut s’interroger sur :

- Les causes d’illicéité qui justifieraient une suppression du modèle : un manquement à l’information des personnes, l’absence de la possibilité d’exercer ses droits, la collecte non justifiée de données sensibles par exemple entraîneraient-elles toutes l’obligation de supprimer le modèle ?

- Le rôle de l’entreprise ayant entraîné un modèle dans la collecte des données : faut-il exiger une suppression du modèle que l’entreprise ait réutilisé un jeu de données publiquement accessible sur un site tel que Kaggle, ou qu’elle ait collectée elle-même les données par scraping sur des sites protégés ?

Le désapprentissage machine pourrait ainsi offrir une alternative au régulateur pour faire valoir les droits des personnes concernées lorsque le manquement ne justifie pas une suppression pure et simple du modèle.

Obstacles et garanties

En théorie, le désapprentissage machine semble être une mesure toute indiquée pour donner suite à une demande d’exercice de droit à l’effacement ou d’opposition au traitement s’il était considéré que le modèle devait être adapté suite à cette demande. Puisqu’il permettrait de s’assurer qu’un modèle ne permet pas d’inférer d’information à propos d’une personne, il pourrait même être recommandé comme bonne pratique de sécurité pour éviter la fuite d’informations personnelles à partir des modèles. Toutefois, comme le décrivent les deux parties qui suivent, sa mise en œuvre présente certaines difficultés, pour des garanties encore incertaines.

Des difficultés techniques

Par nature, l’objectif à atteindre par la tâche de désapprentissage peut sembler vain. En effet, désapprendre les informations relatives à certaines données sans impacter la performance globale du système apparaît paradoxal puisque d’une part, ce sont les informations tirées des données qui décrivent le modèle entraîné, et, d’autre part, on peut s’interroger sur l’intérêt d’avoir ré-entraîné un modèle produisant les mêmes sorties que le modèle initial, ce qui est présenté comme l’objectif théorique du désapprentissage. Ainsi, devant ce paradoxe de fond, le choix des métriques à utiliser pour juger de l’efficacité du désapprentissage pose question. Plusieurs sont proposées dans la littérature :

- la distance euclidienne entre les poids des deux modèles un à un : cette métrique simple n’est pas toujours fiable en raison de l’aléatoire pouvant exister lors de l’apprentissage d’un modèle [2] ;

- le Zero Retrain Forgetting (ZRF) score : la sortie du modèle ré-entraîné sur les données à oublier est comparée à celle d’un modèle initialisé de manière aléatoire et donc n’ayant aucune connaissance des données à oublier. Ce score ne peut être utilisé que pour oublier des classes entières ;

- le taux de succès d’attaques visant à extraire des informations relatives aux données à oublier : afin de mesurer cette quantité, il est généralement nécessaire de définir un protocole d’attaque (par inférence d’appartenance ou par inversion de modèle généralement). Cependant, ce protocole ne sera généralement pas capable de représenter l’exhaustivité des risques existants en pratique (aujourd’hui ou et encore moins à l’avenir) ;

- l’Anamnesis index (AIN) : cet indicateur mesure à quel point un modèle a oublié grâce au nombre d’itérations d’apprentissage nécessaires pour apprendre à nouveau les caractéristiques oubliées. En comparant ce nombre d’itérations à celui nécessaire pour ré-entraîner un modèle entraîné sur un ensemble privé des données à oublier, l’AIN indique d’une part lorsque le modèle n’aurait pas assez oublié, mais également lorsqu’il a trop oublié, ce qui signifie qu’il a également oublié des caractéristiques qui n’étaient pas propres aux données oubliées, ce qui pourrait impacter la performance.

Cet échantillon de métriques permet d’identifier certaines des difficultés majeures de la tâche.

Premièrement, la nature stochastique, c’est-à-dire probabiliste, du procédé d’apprentissage tant dans la répartition des données dans les itérations d’apprentissage[3] que de par les imprécisions de calcul menant à des résultats différents pour un même apprentissage.

Deuxièmement, la nécessité d’un modèle de comparaison : ce modèle est requis au moins dans une première phase expérimentale pour évaluer l’efficacité de la tâche de désapprentissage. Ce modèle, quasiment identique au modèle initial étant généralement entraîné de zéro sur l’ensemble privé des données à oublier, le désapprentissage perd alors tout intérêt puisqu’il est nécessaire de réaliser un entraînement quasi complet. La comparaison n’étant qu’une vérification, cette étape pourrait être négligée, mais une preuve de la capacité de généralisation de la technique de désapprentissage devient alors nécessaire.

Troisièmement, l’opacité de la phase d’apprentissage, et ainsi la difficulté de tracer l’influence des données sur les paramètres du modèle est un obstacle majeur au développement de ces techniques. Cette difficulté, également rencontrée dans la recherche d’explicabilité des modèles d’IA, trouve toutefois certaines solutions dans des publications récentes, comme Koh et al., 2020, qui parvient à identifier le rôle des données d’entraînement sur les prédictions d’un modèle en boîte noire grâce à des « fonctions d’influence ».

Enfin, la problématique du désapprentissage machine est issue du nouveau risque que font peser les attaques par inversion du modèle ou par inférence sur les données d’entraînement. Ce risque, démontré notamment par Fredrikson et al., 2015 sur un modèle de reconnaissance faciale à partir duquel il est possible de reconstituer un visage utilisé dans l’ensemble d’entraînement, est relativement récent : de nouvelles attaques pourraient émerger et remettre en cause l’évaluation du désapprentissage à partir de tentatives d’attaque. Les modèles désappris aujourd’hui pourraient ainsi révéler demain des informations à propos de données qu’ils étaient censés oublier.

Les difficultés de mise en œuvre du désapprentissage apparaissent ainsi conséquentes, alors que les garanties apportées restent peu satisfaisantes, comme détaillé ci-dessous.

Pour quelles garanties apportées ?

Le recensement effectué par Nguyen et al., 2022, fait mention de plusieurs protocoles de désapprentissage machine apportant des garanties formelles, c’est-à-dire vérifiables avec certitude. Toutefois, ces garanties ne peuvent être apportées que dans certains cas particuliers (notamment pour les modèles linéaires ou les modèles bayésiens, parfois seulement sur une classe dans le cas de la classification et non sur les données). Par ailleurs, ces garanties reposent parfois sur la confidentialité différentielle, qui est connue pour avoir un impact important sur l’utilité, tout en offrant des garanties dont la signification pratique est encore confuse[4]. Seules les approches reposant sur un réentraînement partiel du modèle, avec la garantie que les données à oublier n’auront pas été utilisées, semblent fournir des garanties formelles robustes et transparentes. Toutefois, ces techniques ont un coût puisque le modèle doit être ré-entraîné en partie (ou parfois totalement en cas de malchance), et qu’il implique généralement le stockage de résultats intermédiaires ou la conservation prolongée des données d’entraînement.

Par ailleurs, l’impact du désapprentissage sur la performance du modèle ne semble pas encore maîtrisé. Alors qu’il semble admis que le désapprentissage implique une perte de performance du modèle, Nguyen et al., 2020 liste les solutions apportées au cas particulier du « désapprentissage catastrophique », c’est-à-dire une perte significative de performance du modèle le rendant inutilisable, et semble parvenir à la conclusion qu’une solution généralisable reste à découvrir. Cette perte de performance sur laquelle aucune certitude n’existe, pourrait avoir des conséquences désastreuses dans le cas où l’IA aurait des conséquences importantes pour les personnes.

De plus, les possibilités s’offrant à un responsable de traitement malhonnête qui souhaiterait ne pas réaliser le désapprentissage du modèle suite à une demande d’opposition (pour ne pas risquer de perdre en performance par exemple) sont nombreuses. Tout d’abord, Shumailov et al., 2021, montrait que les performances d’un algorithme pouvaient être modifiées de manière ciblée en changeant l’ordre des données d’entraînement. Des portes dérobées pouvaient ainsi être introduites, et il n’est pas inenvisageable que les données puissent être réarrangées pour ré-entraîner le modèle de telle sorte à dissimuler l’influence des données à oublier. Par ailleurs, un responsable de traitement pourrait certainement créer des données fictives très similaires aux données à oublier et laisser penser que les données à oublier ont été supprimées et que leur influence apparente sur le modèle est due aux données similaires.

En pratique, on peut s’interroger sur l’acceptabilité pour les personnes exerçant leurs droits d’une simple déclaration du responsable de traitement ayant eu recours au désapprentissage. En effet, une garantie formelle sur un procédé, entraîne une garantie ad hoc, mais celle-ci n’est pas explicite et la personne cherchant à exercer ses droits pourrait manquer d’une preuve relative à son cas particulier.

Une mesure technique protectrice de la vie privée ?

Le désapprentissage machine semble encore une mesure de protection absente du viseur des homologues européennes de la CNIL, certainement en raison du manque de maturité de la technique. Pour sa part, la CNIL identifie d’ores et déjà certains des obstacles qu’il s’agira de franchir afin de pouvoir promouvoir cette pratique.

Sur les principes généraux

Nombre des techniques observées reposent sur le stockage de résultats intermédiaires permettant de revenir à un certain stade de l’apprentissage ou de retrouver l’influence d’une certaine donnée sur le modèle entraîné. Ces résultats intermédiaires peuvent prendre différentes formes : valeurs du gradient, sous-ensembles de données, fonctions d’influence, etc. Toutefois, dans tous ces cas, elles comportent des informations relatives aux données à oublier qui n’auraient pas lieu d’exister en l’absence de la démarche de désapprentissage. En l’absence d’une étude plus approfondie sur les informations contenues dans ces résultats intermédiaires, on peut ainsi s’interroger sur la compatibilité de ces approches avec le principe de minimisation.

Par ailleurs, l’absence de preuve formelle pour les désapprentissages dans plusieurs situations peut constituer un obstacle pour considérer ces opérations comme permettent l’exercice des droits.

Sur la licéité du désapprentissage

Bien que certains des protocoles existants aient été développés selon l’idée que le traitement des données à oublier doit être le plus réduit possible pour mettre en œuvre le désapprentissage, d’autres reposent sur un traitement conséquent de ces données. Dans le cas d’une demande d’effacement ou d’exercice du droit d’opposition, ce traitement n’est pas interdit, bien qu’il semble logique de le minimiser. Toutefois, si le désapprentissage a lieu en exécution d’une demande de rectification notamment, le droit à la limitation pourrait s’appliquer. La possibilité pour le responsable de traitement de traiter les données pour désapprendre le modèle pourrait alors être remise en question. Cette situation pourrait ainsi obliger le responsable de traitement à entièrement ré-entraîner le modèle sur un ensemble privé des données à oublier.

D’une manière générale, si la technique de désapprentissage semble une voie intéressante pour le droit à l’effacement (ou d’opposition) dans certains cas, son application pour le droit à la rectification ou à la limitation semblent encore plus complexes.

Sur la responsabilité

Lorsque le modèle d’IA entraîné a été partagé à des tiers (cas fréquent dans le cas d’un dispositif commercial « sur étagère ») et qu’une demande d’effacement a été exercée auprès du fournisseur du modèle, l’article 17.2 du RGPD prévoit dans certaines conditions que le fournisseur informe les responsables de traitement qui « traitent ces données à caractère personnel » de cette demande, afin que ceux-ci procèdent à effacement de « tout lien vers ces données à caractère personnel, ou de toute copie ou reproduction de celles-ci ». Les conséquences de ce paragraphe pourraient être que les utilisateurs d’un modèle d’IA contenant des données à caractère personnel informés par le fournisseur de solution, aient l’obligation de supprimer les données concernées et leur influence sur le modèle, s’il était possible de retrouver les données d’entrainement à partir de celui-ci. Si le désapprentissage pourrait à terme être une solution adaptée à ce problème, il semblerait plus adapté que le système soit mis à jour par le fournisseur de solution, qui dispose des données d’entraînement et des compétences techniques, plutôt que par le réutilisateur. Certaines dispositions (contractuelles par exemple), pourraient prévoir un schéma de sous-traitance envers le fournisseur de solution afin d’effectuer l’effacement.

Sur les mesures de sécurité applicables

Lorsque le protocole de désapprentissage repose sur le stockage de résultats intermédiaires, ceux-ci pourraient permettre d’inférer des informations à propos des données d’entraînement. Ces résultats devraient ainsi être sécurisées au moyen des techniques usuelles comme le chiffrement des sauvegardes ou la gestion des habilitations.

Si le désapprentissage implique plusieurs acteurs, comme cela peut être le cas dans l’apprentissage fédéré, certaines techniques pourraient permettre de limiter les connaissances de chacun des acteurs durant la phase de désapprentissage. Les motivations ayant conduit une personne à demander à exercer son droit à l’effacement pouvant être assez personnelles, il peut être recommandé dans certains cas de limiter la liste des personnes ayant connaissance de cette demande et des données concernées. Ainsi, l’utilisation de techniques comme le chiffrement homomorphe lors du désapprentissage pourrait être considérée, dans la mesure des performances exigées.

Sur l’audit du désapprentissage

Comme décrit précédemment, le désapprentissage n’offre que rarement des garanties formelles sur ses résultats. Par ailleurs, même en présence de garanties formelles, il pourrait être particulièrement difficile de vérifier la validité de ces preuves. Ainsi, pour auditer un procédé de désapprentissage, comme dans le cas d’un contrôle visant à prouver que le droit d’effacement a bien été mis en exécution, d’autres approches doivent être trouvées. Les tentatives d’attaque afin de réidentifier les personnes à partir du modèle entraîné semblent la piste à privilégier, toutefois, certaines difficultés persistent. En effet, comment s’assurer de l’exhaustivité de ces modèles d’attaques, de leur efficacité (au regard de la nature stochastique de certains de ces procédés notamment), et de la pérennité de leurs résultats ?

En conclusion, le désapprentissage machine semble être une technique prometteuse dans certains cas où l’influence de données devrait être oubliée d’un modèle entraîné, comme en cas d’empoisonnement du modèle, de dérive des données, ou encore, dans certains cas, pour l’exécution d’un droit à l’effacement. Toutefois, le coût et la complexité de ces techniques semblent encore trop significatifs en comparaison avec les garanties qu’elles apportent.

[1] La spécialisation du modèle est une phase d’apprentissage supplémentaire pendant laquelle un modèle pré-entraîné est entraîné à nouveau sur un ensemble restreint de données présentant des caractéristiques très proches de celles que le système d’IA rencontrera en phase de production.

[2] Les très nombreux calculs nécessaires à l’apprentissage d’un modèle profond comme un réseau de neurones entraînent généralement des différences dans le résultat final : les erreurs de calcul quasiment imperceptibles réalisées par les machines modernes conduisent à des erreurs visibles lorsqu’elles s’accumulent.

[3] Lors de l’apprentissage, les données sont réparties selon des sous-ensembles, ou batchs, de manière aléatoire. Chaque batch influençant la suite de l’apprentissage, l’ordre de visite des données possède une importance qu’il est difficile d’estimer a posteriori ou de mesurer durant l’apprentissage.

[4] La confidentialité différentielle repose sur le choix d’un seuil epsilon, ε, dont la valeur théorique manque encore de réalité pratique : il est difficile de savoir exactement le niveau de protection qu’une certaine valeur permettra d’atteindre.