Sans données, le futur de l’IA restera artificiel

Rédigé par Anuchika Stanislaus

-

30 août 2016Terreau de la science-fiction, l’intelligence artificielle (IA) n’est déjà plus un fantasme, mais bel et bien une réalité. Elle surprend, impressionne, terrorise, et fait couler beaucoup d’encre, mais la connaît-on vraiment ? Quels sont et seront ses impacts sur la vie privée ?

Les définitions proposées par un article du site L’Influx invitent à distinguer deux types d’IA:

- « L’IA faible [qui] désigne une machine capable de simuler l’intelligence, de tenir une conversation, de rechercher des informations dans une masse de données avant de les traiter en vue d’un objectif précis. »

- « L’IA forte, l’intelligence artificielle consciente, capable d’éprouver des émotions et des sentiments». Par exemple, pratiquer l’humour, avoir de l’imagination, de l’empathie, des sentiments. »

Aujourd’hui, seule « l’IA faible » a de réelles applications.

L’avènement des algorithmes d’apprentissage redéfinit «l’intelligence»

Dans nos pratiques quotidiennes en 2016, il est déjà possible d’interagir avec des technologies dotées d’une intelligence artificielle : par exemple, votre assistant virtuel (Siri, Google Now ou Alexa), ou l’identification suggérée des photos postées sur Facebook.

L’intelligence artificielle utilise des algorithmes d’apprentissage dit automatiques, machine learning dont la principale capacité est de généraliser un ensemble de traits et d’en créer un modèle. Elle prend une toute nouvelle dynamique avec l’apprentissage profond, deep learning, auto-apprentissage d’un algorithme sans mécanisme d’apprentissage préalable. Elle est essentiellement utilisée dans la reconnaissance des formes dans les images et la parole. Sa principale capacité est de prendre des décisions : une voiture autonome s’arrête « à la vue » d’un enfant qui traverse la route, la voiture analyse et décide instantanément de s’adapter à la situation inédite. Ceci n’est déjà pas sans poser de nombreuses questions quant au dilemme moral posé par la prise de certaines décisions.

Les algorithmes prédictifs, le défi de l’intelligence artificielle

Les intelligences artificielles d’aujourd’hui sont loin d’être omnipotentes et restent spécialisées par domaine : détrôner l’intelligence « humaine » au jeu de Go ou à Jeopardy, rédiger des articles, cuisiner votre plat préféré, écrire un scénario de film… L’aptitude à la compréhension du sens commun est l’objectif recherché pour obtenir une intelligence artificielle multifonctionnelle, rendant une machine capable d’être à la fois journaliste, scénariste et « machine au foyer ». C’est l’apprentissage dit prédictif qui selon Yann LeCun, directeur IA de Facebook, permettra de l’atteindre. Une intelligence rationnelle (logique, analyse, prise de décision), stratégique (planification, organisation), temporelle (consciente de l’axe du temps) et situationnelle (adaptation à l’inédit) serait un cocktail gagnant où l’intelligence artificielle serait capable de prédire des événements à partir de séquences d’autres événements.

L’apprentissage profond annonce de grandes avancées dans l’analyse préventive des données biomédicales, notamment dans la lutte contre le cancer et les maladies génétiques. On a déjà pu le constater avec le projet Watson d'IBM, qui a détecté une leucémie chez un patient que les médecins n'avaient pas repérée, ou encore AIME (Artificial Intelligence in Medical Epidemiology), une intelligence artificielle qui détecte des épidémies avant même leur déclenchement. Appliquée au domaine médical, l’intelligence artificielle relève cependant de l’exploitation de données personnelles sensibles, et pose des questions quant au respect de la loi informatique et libertés.

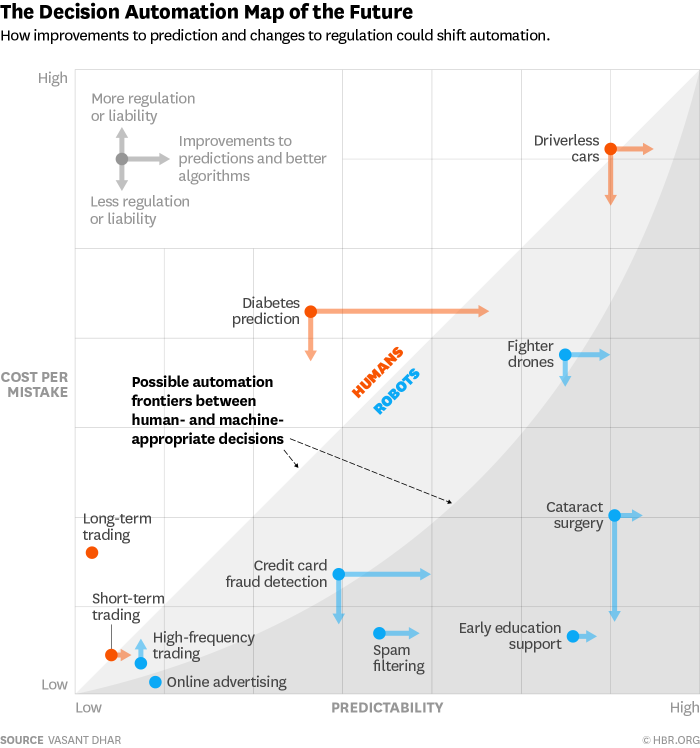

A Marseille, l’intelligence prédictive deviendra bientôt opérationnelle. Grâce au big data et au deep learning, des caméras de surveillance prédictives disséminées partout dans la ville, promettent d’analyser les mouvements inhabituels et comportements suspects. Il en est de même avec le système anti-fraude du Centre de transactions et d’analyse, en Australie. . L’adoption de ce type de système, si l’on n’y prend pas garde, risque cependant de transformer l’algorithme en « machine à biais ». Selon Antoinette Rouvroy, « les machines ne feront jamais que refléter passivement, tout en les immunisant (partiellement) de la critique, les biais et préjugés sociaux dominants. Ce ne sont pas tant les machines (les algorithmes) qui sont en cause, que la manière dont nous produisons et enregistrons les données à propos de la réalité sociale. » Des critiques et des risques auxquels tentent déjà de répondre des chercheurs : la Decision Automation Map, proposée par Vasant Dhar, professeur à la New-York University, évalue les systèmes prédictifs selon un rapport coût / efficacité. Plus précisément il s’agit d’arbitrer entre le niveau de prédictibilité et le coût généré par une erreur afin de déterminer pour quel usage faut-il choisir, ou bien se passer des algorithmes prédictifs (voir graphique ci-dessous).

Le e-business laissera place au «IA-Business»

Au-delà des questions liées à la sécurité, le développement d’une IA forte pourrait aussi permettre de renforcer l’efficacité du marché de la publicité. Ne sourcillez plus devant le prochain article qui vous plaira en magasin, le deep learning permettra grâce à ses algorithmes émotionnels de détecter vos émotions, et de vous envoyer les contenus publicitaires correspondant à celles-ci. Couplé à de l’informatique affective, en plus de reconnaître et modéliser vos émotions, l’intelligence artificielle saura les exprimer à son tour. Dans le futur, l’autonomisation de ces IA pourrait poser la question de nouvelles règlementations qui leur seraient directement dédiées. Aurélie Pols, consultante spécialisée en données et vie privée, considère dans un article de Wired que les questions éthiques ne se posent pour les entreprises que si la variable financière entre en jeu. Elle compte notamment sur la notion de responsabilité intégrée au Règlement Européen applicable en 2018, pour une protection des données personnelles à la fois plus responsabilisante et plus éthique.

Le devenir de l’intelligence artificielle vers le transhumanisme

Le cerveau est le point commun des ventures de l’empire Google, disait Laurent Alexandre, membre du comité de la prospective de la CNIL. Nous assisterons d’ici deux décennies, selon Raymond Kurzweil (transhumaniste devenu directeur de l’ingénierie chez Google Alphabet), à la fusion de l’intelligence artificielle et biologique (révolution « NBIC »). Plausible ou non, les dangers qui en résulteraient iraient de pair avec les risques de neuro-hacking ou de neuro-manipulation. C’est dans l’interaction entre les humains et les algorithmes que naissent les questions de vie privée et d’éthique. Quelle régulation et quels droits pour l’IA ? Quelle gouvernance pour quelles valeurs promues par la société ?

Illustration : Flickr CC BY 2.0 Lisa Williams