Al(t)gorithmes (3) : Streaming, des algorithmes pas toujours responsables

Rédigé par Octave Aribaud

-

13 décembre 2022La majorité des contenus consommés en ligne est aujourd’hui filtrée par des algorithmes de recommandation, 80% des vidéos visionnées sur Netflix par exemple (chiffres de 2016). Au prisme de la protection des données personnelles, ces systèmes de recommandation ne sont pas cependant exemptés de certaines problématiques : les biais algorithmiques, la transparence et la responsabilité, les fuites de données.

- Article 1 : Al(t)gorithmes (1) : des recommandations toujours plus gourmandes en données personnelles ?

- Article 2 : Al(t)gorithmes (2) : Perceptions des utilisateurs de streaming

- Article 3 : Al(t)gorithmes (3) : Streaming, des algorithmes pas toujours responsables

- Article 4 : Al(t)gorithmes (4) : Musiconomics et protection des données personnelles

Le 21 juin 2022, la Défenseure des Droits appelait à replacer le principe de non-discrimination au cœur du projet de règlement de la Commission Européenne sur l’Intelligence Artificielle dévoilé le 21 avril 2021. Quand bien même elle concède que le recours aux algorithmes est à l’origine de progrès majeurs dans de nombreux domaines tels que la justice, l’assurance ou la médecine, elle y voit tout de même une potentielle source de risques pour les droits fondamentaux. C’est aussi l’avis de l’EDPB et du CEPD qui, dans un avis conjoint sur le même projet de règlement, notent le risque élevé de discrimination lié à certaines utilisations de l’IA. Récemment, en raison de nombreuses affaires médiatiques, la modération des réseaux sociaux est devenue un cas d’école de la « discrimination » dans l’étude des algorithmes de modération. Par exemple, courant mai 2020, sur Facebook et Twitter, des comptes de militants LGBT ont été temporairement suspendus pour avoir ouvertement affiché leur orientation sexuelle. Comme l’explique Thibault Grison pour The Conversation, sur ces réseaux sociaux, certains mots-clés comme « pédé » ou « gouine » sont associés à du contenu nécessairement haineux sans prendre en compte le contexte d’énonciation et la réappropriation militante de ces termes. Autre exemple, une étude de 2020 a montré que la recommandation sur les plateformes de musique en streaming met davantage en avant des artistes masculins que féminines. De nombreuses controverses sont ainsi posées par l’usage des systèmes de recommandation par les plateformes de streaming.

Biais algorithmiques et discrimination systématique

S’il est souvent dit que la personnalisation algorithmique permettrait une meilleure satisfaction des besoins utilisateurs, ce n’est pas toujours le cas. Dans une interview donnée au LINC, Philippe Besse, professeur de Mathématiques à l'université de Toulouse-INSA et spécialiste des questions de discrimination algorithmique affirmait que « contrairement à des prises de position très naïves, les décisions algorithmiques ne sont pas plus objectives que des décisions humaines ». Dans l’industrie du streaming, on peut les définir comme une mauvaise représentation systématique d’une population dans les contenus recommandés par les plateformes de streaming. Les biais peuvent apparaître à différents moments du cycle de vie de l’algorithme. Selon Thibault Grison, on peut les regrouper en trois catégories. Le premier type de biais est statistique et tient aux jeux de données utilisés pour nourrir les algorithmes de machine learning. Cathy O’Neil, autrice de l’ouvrage Algorithmes : la bombe à retardement (2018) pointe notamment du doigt l’utilisation de bases de données historiques qui contribuent à la création de « boucles de rétroaction » : par la répétition de problématiques passées elles ne font que renforcer les problèmes existants. Le second type de biais est nommé « biais de société », il traduit les représentations biaisées des concepteurs de programmes transférées au moment de l’élaboration de leur code. Ce type de biais est évoqué dans de nombreux travaux tels que ceux de J. Jeng & H. Chong (2021) ou encore de A. Melchiorre (2021). Et en effet, les systèmes de recommandations des grandes plateformes de streaming ont été créés dans des bureaux à New York, Londres, Stockholm ou Paris, par des équipes d’ingénieurs issues de classes sociales plutôt favorisées dont il est probable que leurs antécédents et leurs expériences se soient en partie projetés dans la création de leurs algorithmes. Finalement, les objectifs de rentabilité et les critères garantissant l’efficacité des algorithmes forment une troisième catégorie de biais. C’est notamment ce que nous écrivons dans le quatrième article de ce dossier, quand nous évoquons le poids des investisseurs sur les décisions prises par les plateformes. Dans le secteur du streaming, les biais se concentrent sur deux domaines : le genre et la diversité culturelle.

Les biais de genre

Ceux-ci sont notamment identifiés par les travaux de C. Bauer et son équipe de recherche. Celle-ci remarque que, dans les playlists générées automatiquement, les artistes femmes n’apparaissaient généralement pas avant le 7ème ou le 8ème morceau recommandé. Bien que 45% des utilisateurs de plateformes de streaming soient des auditrices, 23.2% seulement des artistes écoutés sur Spotify sont des femmes ou des groupes mixtes. Ce biais joue sur la visibilité des artistes femmes, et donc en fin de compte sur leur popularité et leur revenu. Alors que, par le passé, la musique était majoritairement diffusée sur des radios publiques, ou régulées indirectement par l’État, il était plus facile de rendre les distributeurs responsables de leur non-parité. Ainsi, en France, la délibération n°2015-2 du 4 février 2015 relative au respect des droits des femmes - qui précise les conditions d’application de la loi n°2014-873 du 4 août 2014 sur l’égalité réelle entre les femmes et les hommes - confie à l’Arcom (issu de la fusion du Comité Supérieur de l’Audiovisuel et de l’Hadopi) la mission de veiller : « à une juste représentation des femmes et des hommes dans les programmes des services de communication audiovisuelle ». Aujourd’hui, les plateformes de streaming ne sont pas concernées par une telle régulation, ce qui rend plus difficile de les tenir pour responsable. Elles pourraient le devenir à la suite du vote le 5 juillet 2022 du Digital Services Act, qui vise à responsabiliser les plateformes sur les contenus.

Mais d’où viennent ces biais ? Les musiciennes sont d’abord très largement sous-représentées dans les bases de données et les catalogues proposées par les plateformes. Dans une étude, A.B. Melchiorre compare les recommandations effectuées dans deux mondes virtuels différents. Un monde où les auditeurs écoutent de la musique à partir d’une base de données « normale » et un autre où les auditeurs écoutent de la musique à partir d’une base de données où les femmes sont sur-représentées. Il remarque que, même dans le second monde, les playlists générées par algorithmes contiennent d’avantage d’artistes masculins. Ce qui permet d’attester de la présence de biais dans la construction des algorithmes de recommandation. Mais les biais déjà présents dans les bases de données et renforcés par les algorithmes sont encore accentués par le biais de popularité. C. Bauer (A. Anderson, 2022) l’explique simplement, « les morceaux qui sont déjà très populaires sont plus susceptibles d'être recommandés à d'autres personnes, donc ils sont plus susceptibles d'être écoutés, ce qui augmente à nouveau les chances qu'ils soient recommandés. Ainsi, les titres populaires deviennent plus populaires, tandis que les titres moins populaires restent dans l’ombre ». Rapporté à l’étude des biais de genre, les artistes masculins étant déjà plus populaires car d’avantage recommandés par les algorithmes, leur gain de popularité les rend encore plus visibles, ce qui, au final, contribue à exclure les musiciennes des playlists générées automatiquement.

Si les plateformes de streaming ont connaissance de ces biais sexistes, il est difficile selon C. Bauer de savoir si elles cherchent effectivement à les résoudre dès lors que leur fonctionnement est opaque. Les plateformes cherchent à protéger leurs algorithmes, qui leur permettent de se différencier entre concurrents. Pour atténuer les biais de genre, certains chercheurs proposent de « débiaiser » les algorithmes à travers des systèmes de classement. Une technique qui consiste à intégrer des indices de représentativité au sein des règles édictées dans la construction des algorithmes de recommandation.

Les biais culturels

Le biais culturel est le second biais commun aux plateformes de streaming. Si la numérisation, le téléchargement puis le streaming ont permis de remettre en question la domination commerciale de la musique anglo-saxonne, les plateformes de streaming doivent aujourd’hui tenir compte de cette mondialisation.

Ces dernières années, plusieurs chercheurs se sont intéressés aux biais culturels véhiculés par les playlists générées par des algorithmes. Par exemple, bien qu’une proportion de plus en plus large des utilisateurs de plateformes de streaming ne soient pas anglo-saxons, la majorité des hits restent en langue anglaise. Cette sous-représentation des musiques non-anglo-saxonnes peut amener à percevoir la musique culturellement diverse comme de moindre valeur. Et, sur le long terme, dévaloriser certaines cultures au profit d’autres. Les plateformes de streaming pourraient pourtant intégrer davantage de styles et de langues au sein de certaines playlists spécifiquement conçues pour une région, voire promouvoir davantage les artistes de langues et culture diverses dans un genre spécifique.

Spotify a annoncé le lancement d’une nouvelle initiative nommée « Global Sound » qui cherche à accroître les échanges musicaux entre les continents et idéalement à transformer des tubes locaux en phénomènes mondiaux. Une playlist nommée « Global X » met spécifiquement en avant des « crossovers ». Rocio Guerrero, responsable de ce programme explique ce terme en désignant un mix de différents genres, de différentes langues ou des chansons hybrides. Alors que la playlist était à l’origine très pop, progressivement les musiques proposées sont de plus en plus variées afin d’habituer l’auditeur à des sonorités et des langues différentes. Cependant, malgré la confiance de Rocio et de son équipe sur la capacité à faire émerger des hits internationaux, l’assimilation de ces sons demandera d’abord des recommandations produites par des algorithmes ainsi qu’un changement dans le comportement et les habitudes des utilisateurs. Ce qui peut prendre beaucoup de temps. Il sera notamment intéressant d’observer comment la musique populaire évolue au fur et à mesure que sont intégrés de nouveaux genres.

Transparence, explicabilité et responsabilité

Les algorithmes de recommandation posent un second enjeu, celui de la transparence, qui touche deux publics en particulier. En premier lieu, les consommateurs qui font l’objet de suggestions automatisées. Soulevons ici un point de tension. Avant de proposer une recommandation, les algorithmes réalisent généralement un profilage. Le profilage est défini dans l’article 4 du RGPD comme « toute forme de traitement automatisé de données à caractère personnel consistant à utiliser ces données à caractère personnel pour évaluer certains aspects personnels relatifs à une personne physique, notamment pour analyser ou prédire des éléments concernant le rendement au travail, la situation économique, la santé, les préférences personnelles, les intérêts, la fiabilité, le comportement, la localisation ou les déplacements de cette personne physique ». Basé sur ce profilage, les algorithmes vont réaliser des segmentations puis proposer des contenus. Tout traitement de ce profilage doit cependant faire l’objet d’une attention particulière, car il soulève par nature des risques importants pour les droits et libertés des personnes. L’article 22 du RGPD encadre notamment les processus de prise de décision entièrement automatisés en prévoyant une supervision par un opérateur humain, lorsqu’elles produisent des effets juridiques ou significatifs pour la personne concernée. L’article 13 et 14, quant à eux, prévoient l’obligation d’informer les personnes de l’existence de tels traitements. Il est considéré qu’une décision a un impact significatif lorsqu’elle a pour conséquence d’influencer l’environnement de la personne, son comportement, ses choix ou d’aboutir à une forme de discrimination. Même s’il semble peu probable qu’une simple recommandation musicale soit considérée comme ayant un impact significatif sur une personne et donc soumis à l’article 22, nous avons montré dans le second article de ce dossier que les algorithmes de recommandation ont un impact sur la construction de l’individu. Dans un second temps, la transparence est aussi utile pour les entreprises qui possèdent les systèmes de recommandation puisque cela peut leur permettre de les améliorer, s’ils mettent en place des mécanismes de retours par une communauté d’utilisateurs ou de développeurs.

Le principe de transparence des algorithmes, est entré dans le droit français avec la loi pour une République Numérique en 2016 pour les algorithmes publics. Ce texte impose notamment aux organismes publics de fournir à l’individu concerné un ensemble d’informations concernant l’algorithme ainsi que son fonctionnement en détail. Le terme est plus largement utilisé dans différents contextes, donnant lieu à différentes interprétations dans la manière dont il faudrait appliquer ce principe. Néanmoins, comme le confiait Alan Rusbrudgern, membre du Facebook Oversight Board, “At some point we’re going to ask to see the algorithm, I feel sure. (…) Whether we’ll understand when we see it is a different matter”(« Un jour, nous demanderons certainement à voir l’algorithme… est-ce que nous le comprendrons ? C’est une autre histoire… »). En effet, les plateformes de streaming possèdent des algorithmes faisant plusieurs millions de lignes de code, il ne fait pas de doute que leur mise en accès ne serait donc pas nécessairement intelligible.

Certains préfèrent raisonner en termes d’« explicabilité » et « d’interprétabilité ». Une décision algorithmique est dite explicable « s’il est possible d’en rendre compte explicitement à partir de données et caractéristiques connues de la situation. Autrement dit, s’il est possible de mettre en relation les valeurs prises par certaines variables (les caractéristiques) et leurs conséquences sur la prévision, par exemple d’un score, et ainsi sur la décision ». Le terme d’interprétabilité, lui, renvoie à la capacité d’identifier les caractéristiques ou variables qui participent le plus à la décision, voire même d’en quantifier l’importance. Derrière le concept d’interprétabilité se place aussi l’ambition de faire comprendre à l’utilisateur des processus parfois très techniques. Le terme d’interprétabilité cache donc une dimension de design qui agit comme un medium pour faciliter la vulgarisation de certaines décisions.

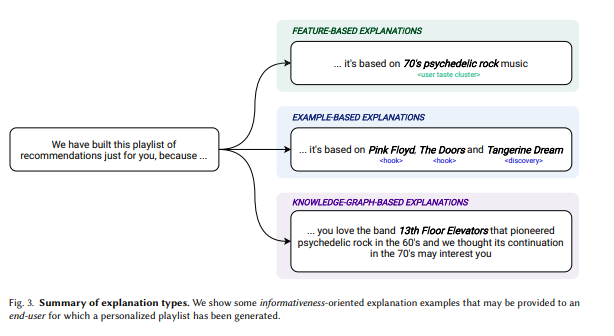

Amazon a très tôt intégré des moyens pour l’utilisateur de comprendre les suggestions qui lui sont faites, en justifiant par une phrase les recommandations proposés tels que « Les clients qui ont acheté ce produit ont aussi acheté … », une explication qui reste partielle mais qui provoque l’adhésion du consommateur. Du côté de la musique en streaming, les travaux de D. Afchar proposent trois manières de rendre intelligible les recommandations faites aux utilisateurs (voir le schéma ci-dessous) : en soulignant les caractéristiques les plus importantes du processus de suggestion, en comparant le titre recommandé avec d’autres titres appréciés par l’utilisateur, enfin, en expliquant le raisonnement réalisé par l’algorithme de recommandation. Certains outils ont d’ailleurs été développé pour permettre aux développeurs d’améliorer l’interprétabilité de leurs systèmes de recommandation. On peut notamment penser aux librairies Python Shap et Lime qui permettent aux utilisateurs, via la construction de graphiques, de mieux comprendre les différentes variables qui ont mené aux recommandations qui leur ont été suggérées.

Schéma des types d'explication de recommandations

Parler de transparence des algorithmes, d’explicabilité et d’interprétabilité appelle à se poser la question de la responsabilité. Quand les technologies échouent – par exemple en étant à l’origine d’une recommandation biaisée ayant des effets discriminatoires – à qui revient la faute ? Quand les décisions sont prises par des modèles de décisions simples, il est simple d’attribuer la faute aux concepteurs d’algorithmes. Mais, pour des modèles de machine learning agissant en boîte noire, attribuer une faute est largement plus difficile. En 1996 déjà, H. Nissenbaum, hostile à une société de plus en plus dépendante des systèmes informatiques, s’inquiétait de la dilution de la responsabilité en notant l’apparition de quatre barrières :

- « de nombreuses mains », pour faire référence au problème de l'attribution de la responsabilité morale pour des résultats causés par de multiples acteurs moraux ;

- « les bugs », excuses utilisées par les développeurs de logiciels afin de se décharger de toute responsabilité en suggérant que les erreurs logicielles sont inévitables ;

- « l'ordinateur en tant que bouc émissaire », qui consiste à rejeter la faute sur les ordinateurs comme s'ils étaient des acteurs moraux ;

- « la propriété sans responsabilité », le laissez-passer accordé à l'industrie du logiciel pour nier toute responsabilité, en particulier par le biais d'accords sur les conditions de service.

Ces vingt dernières années, l’exploitation intensive de mégadonnées et du machine learning n’ont fait que renforcer ces barrières. Pour repenser la responsabilité, les travaux de A-F. Cooper invitent à repenser l’œuvre de Nissenbaum autour de deux axes. Premièrement l’attribution de la faute, qui permet de situer la responsabilité. Le second axe consiste à replacer la responsabilité dans un cadre social, qui implique que nous exigeons un certain comportement les uns des autres et réagissons négativement aux manquements des autres à ces exigences. Le concept de « responsabilité » est d’ailleurs au centre de l’esprit du RGPD et est incarné en la personne du responsable du traitement – au titre de l’article 24 – qui est la personne physique ou morale qui détermine les finalités et les moyens d’un traitement, c’est-à-dire l’objectif et la façon de le réaliser.

La question de la responsabilité invite à se poser la question de l’éthique des algorithmes de recommandation. En 2017, à l’occasion de son rapport « Comment Garder la Main ? » sur les enjeux éthiques des algorithmes et de l’intelligence artificielle, la CNIL dégageait deux principes fondateurs pour une intelligence artificielle au service de l’humain. Un principe de loyauté d’abord selon lequel « l’intérêt des utilisateurs doit primer ». Un principe de vigilance/réflexivité ensuite qui constitue une réponse directe à la nature imprévisible des algorithmes de recommandation en invitant à mobiliser régulièrement l’ensemble de la chaîne algorithmique pour assurer un dialogue entre les différentes parties prenantes. Les algorithmes de recommandation doivent eux aussi être pensés en accord avec ces différentes valeurs. Aujourd’hui, les plateformes de streaming commencent à prendre en compte la nécessité d’adopter certaines pratiques. En témoignent les trois ouvertures de poste publiées par Spotify pour des chercheurs travaillant sur l’éthique de l’intelligence artificielle.

Atteinte à la vie privée

Le recours aux algorithmes de recommandation par les plateformes de streaming pose finalement des questions d’atteinte à la vie privée. Les systèmes de recommandation sont formés à partir des données que l’utilisateur a consenti à partager ou de données extraites de ses comportements. Les systèmes de recommandation, comme toutes les intelligences artificielles, peuvent être victimes d’attaques dont le LINC a réalisé une taxonomie en avril 2022. Or, la fuite de ces données hors des systèmes de recommandation pose par exemple de graves problèmes de confidentialité. Récemment, les travaux M. Zhang et al. (entre autres) ont montré qu’il était possible de récupérer des données utilisateurs sur les systèmes de recommandation via des attaques dites « par inférence d’appartenance » qui permettent à un attaquant d’acquérir des connaissances sur les données utilisées pour la production de modèles IA. En plus de ces menaces dites « explicites », Y. S. Resheff et al. théorisent aussi des menaces « implicites » qui consistent à matcher des données avec des sources d’informations externes pour découvrir des informations personnelles sur les utilisateurs.

Vers des algorithmes de recommandation soucieux de la vie privée des utilisateurs

A la vue de ces différents enjeux, il semble donc nécessaire de construire des systèmes de recommandations plus soucieux de la vie privée des utilisateurs et des risques éthiques liés aux biais notamment. Dans ses travaux, R. Sato, affirme que de tels systèmes de recommandation sont rares, et ce pour trois raisons. D’abord parce qu’il n’est pas démontré que les systèmes de recommandation éthiques sont efficaces. Un système non-efficace pourrait engendrer une perte de profit pour les entreprises qui ne sont donc pas forcément motivées par l’implémentation de tels systèmes. Ensuite les critères éthiques peuvent différer entre les utilisateurs d’un service ce qui crée une confusion quant aux mesures à implémenter. Finalement, les entreprises peuvent refuser de rendre leurs algorithmes transparents, ce qui rend difficile pour les utilisateurs d’estimer l’éthique des algorithmes de recommandation.

Si la régulation et notamment les textes européens sur le numérique (RGPD, DMA, DSA…] sont un moyen dont nous disposons pour pousser à la création de modèles plus vertueux, la concurrence pourrait elle aussi y pousser. En effet, l’imitation est au cœur des mécanismes de compétition. On peut dès lors espérer que, lorsqu’une première entreprise aura communiqué à propos de la sécurité de ses pratiques, toutes ses concurrentes chercherons à adopter des pratiques semblables. Par exemple, quand la plateforme de streaming Netflix a émergé, de nombreuses plateformes de VOD se sont tournées vers un modèle similaire pour ne pas se faire dépasser par cette nouvelle technologie. Dans le prochain article de ce dossier, nous reviendrons sur la compétition entre les plateformes de streaming et mettrons en évidence les différentes logiques économiques et politiques existantes.