Voitures autonomes : les erreurs des intelligences artificielles tueront-elles le tuning ?

Rédigé par Armand Heslot

-

05 juin 2018Quand les voitures autonomes ne parviennent pas à reconnaitre des autocollants posés sur des voitures ou des panneaux de signalisation, elles nous apprennent beaucoup sur les conséquences pour nos sociétés de la multiplication de ces machines intelligentes, et notamment pour certaines de nos libertés, même les plus anodines.

Les progrès des outils actuels d’intelligence artificielle, en particulier ceux s’appuyant sur l’apprentissage automatique, sont fascinants. Pour autant, ces machines pseudo-intelligentes se trompent parfois. Leurs erreurs sont très enrichissantes à analyser, car très particulières et liées au mode de fonctionnement « non-humain » de ces outils.

Les systèmes d’IA sont généralement présentés comme étant capables de meilleures performances que les humains dans certains domaines. Le cas des véhicules autonomes est une bonne illustration de ce qui est présenté comme un axiome : pour les promoteurs des véhicules autonomes, le fait de remplacer tous les conducteurs humains par des systèmes d’IA entraînera une baisse très importante des accidents de la route. Que cette assertion soit vraie ou fausse, nous pouvons d’ores et déjà formuler une hypothèse : les accidents impliquant des véhicules autonomes n’auront rien à voir avec les accidents impliquant des humains.

Ainsi, les véhicules autonomes s’appuient sur toute une gamme de capteurs pour appréhender leur environnement et prendre les décisions adéquates : des radars, des lidars, des caméras… Les données issues de ces capteurs sont ensuite transmises à un système de traitement complexe incluant des systèmes d’IA, qui sont chargés d’analyser et d’interpréter ces données, puis de prendre des décisions en conséquence.

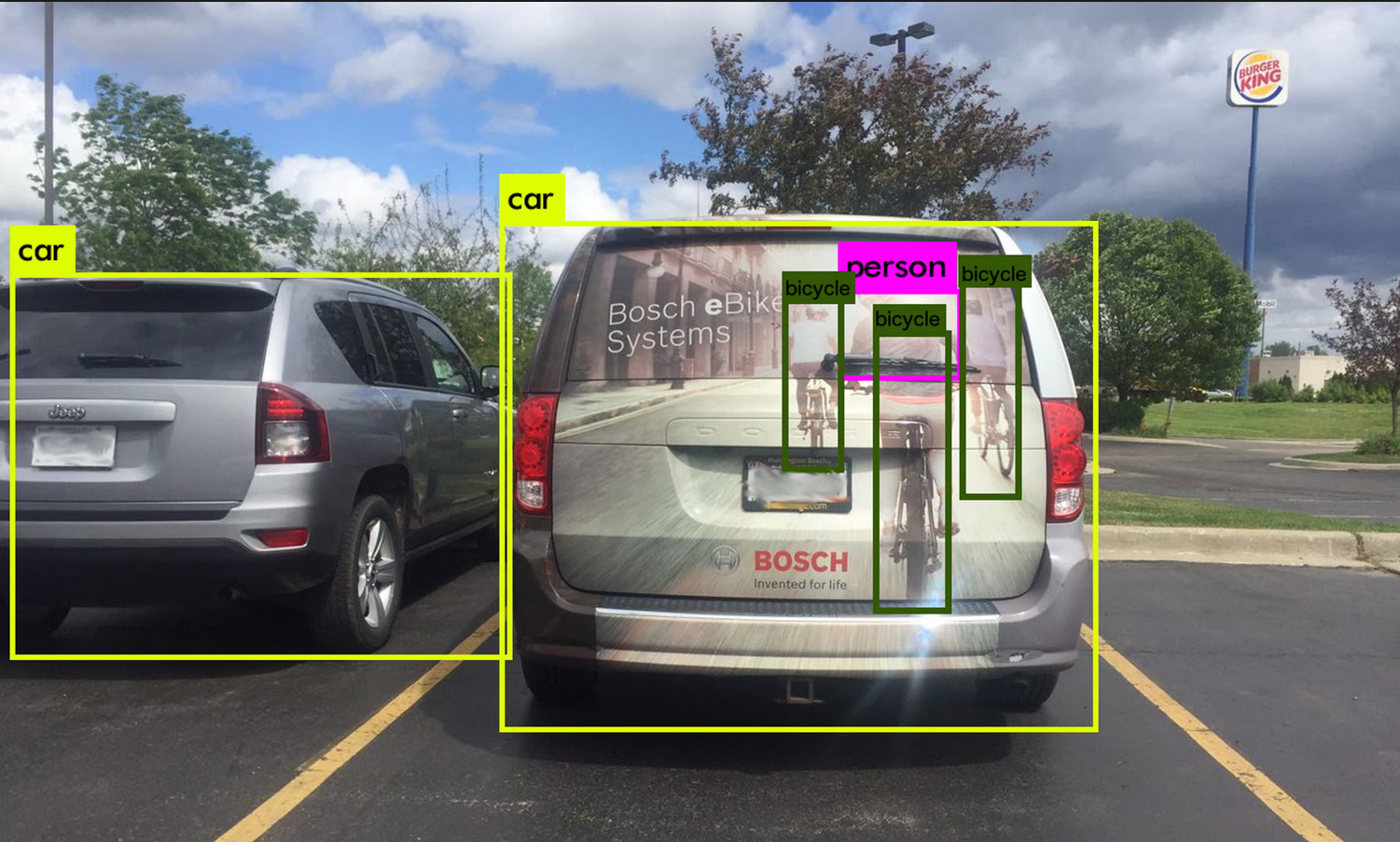

L’exemple ci-dessous, extrait d'un article du Guardian, est une illustration d’un type d’erreur que seul un système d’IA basé sur de l’apprentissage automatique est susceptible de faire : une décalcomanie publicitaire a été apposée sur le hayon arrière d’un véhicule, représentant des cyclistes utilisant des vélos électriques. Pour un humain il est évident qu’il s’agit d’une décoration, tandis que pour le système de reconnaissance d’image il s’agit de la juxtaposition d’une voiture, de trois vélos, et d’une personne. On peut aisément imaginer les conséquences d’une telle erreur lorsqu’elle sera commise par un véhicule autonome, qui pourra prendre une décision potentiellement désastreuse de freinage ou de changement de direction.

Evidemment, une solution optimiste serait d’imaginer que les progrès technologiques permettront d’éliminer très rapidement ces erreurs au fur et à mesure de la sophistication croissante des systèmes d’IA utilisés dans les véhicules au fur et à mesure de l’accumulation des kilomètres de test. Pour autant on peut aussi imaginer un autre scénario prospectif et dès maintenant extrapoler le fait que le jour où toutes les voitures seront autonomes, la pratique du tuning et l’apposition de décors sur les voitures sera très étroitement encadrés afin d’éviter à tout prix ce type d’erreur, qui reste aujourd’hui anecdotique mais aura demain des conséquences potentiellement fatales.

Tout comme le dilemme du tramway, cet exemple nous apporte un enseignement sur les enjeux politiques liés à l’utilisation croissante des systèmes d’IA : il faudra réinventer la régulation pour l’adapter à leurs spécificités et à la manière qu’ont ces outils techniques d’analyser le monde et de prendre des décisions. Penser que ces machines pensent « comme nous, mais en mieux » est un postulat erroné et ne permettra pas de réguler efficacement leur usage.

Illustration de titre : Photo by The Creative Exchange on Unsplash