L’autocontrôle, un nouvel apprentissage pour l’IA [3/3]

Rédigé par Alexis Leautier

-

16 juillet 2024Face à la prolifération de contenus liés à la désinformation, qualifiés de TVE (terroriste, violents ou extrêmes, voir l’article précédent), ou visant à influencer les électeurs (hypertrucages, publicités politiques non qualifiées comme telles), ainsi qu’aux risques des systèmes algorithmiques utilisés pour la recommandation ou le ciblage et pouvant être exploités par des acteurs étrangers (au moyen de comptes automatisés appelés bots notamment), des mesures de contrôle semblent plus que nécessaires. Certaines sont d’ores et déjà mises en œuvre par les plateformes elles-mêmes ou par les Etats. Les tiers, comme la société civile et les chercheurs, jouent également un rôle crucial dans la régulation en pointant les risques ou en identifiant les manquements des plateformes à leurs obligations.

Les autorités de contrôle publiques

Un tour d’horizon réalisé par l’organisation IFES montre que les travaux visant à construire la résilience contre les opérations d’influence en amont des élections européennes de 2024 sont très nombreux. Parmi eux, certains touchent à l’amélioration de la qualité de l’information dispensée par les médias ou encore à l’éducation des citoyens, mais seuls la France et la Suède semblent avoir créé des agences dotées de compétences techniques : Viginum et la Psychological Defense Agency. La commission européenne quant à elle repose principalement sur le financement de projets tels que le Consortium EDMO (European Digital Media Observatory) pour lutter en pratique contre la désinformation. Les services de la Commission s’attachent ainsi davantage à surveiller l’application des textes, avec l’ECAT (European Center for Algorithmic Transparency) en ce qui concerne le RSN, ou le bureau de l’IA pour ce qui est du Règlement IA. Ces tâches sont parfois déléguées à des autorités nationales, comme dans le cas du RGPD, ou de certaines dispositions du RSN.

En France, Viginum a pour mission de détecter et caractériser les ingérences étrangères via l’étude de phénomènes inauthentiques sur les plateformes (comme les comptes suspects, les contenus malveillants, les comportements anormaux, aberrants ou coordonnés). Cette unité du Secrétariat Général de la Défense et de la Sécurité Nationale, qui compte plusieurs data scientists, conduit des recherches sur les techniques de détection des ingérences étrangères. Elle a récemment publié un article proposant un cadre pour l’identification et la catégorisation des bots sur X grâce à l’analyse des données, sur la base de leurs caractéristiques et de leur comportement. Les travaux d’un autre organisme public, le PEReN, ou Pôle d’Expertise de la Régulation Numérique viennent appuyer les missions des autorités de surveillance et de régulation comme Viginum ou l’Arcom en leur fournissant des outils permettant par exemple de détecter les contenus artificiels, d’analyser les rapports sur la modération de contenu fournis par les plateformes, ou encore d’analyser les bulles de filtres créées par les algorithmes de recommandation.

Bien que ces travaux portent leurs fruits, la caractérisation par Viginum du réseau pro-russe « Portal Kombat » en est une preuve, la mise en œuvre de ces techniques par les autorités publiques n’est pas sans risque pour la vie privée des usagers des plateformes. Comme l’a rappelé la CNIL dans son avis sur la création de Viginum, l’existence de cette surveillance peut avoir des conséquences pour les utilisateurs et notamment modifier leurs comportements en ligne. Par ailleurs, si ces services sont jugés nécessaires et proportionnés dans une société démocratique, le risque qu’ils soient détournés de leur finalité initiale existe, soit par un acteur malveillant (un employé peu scrupuleux qui parviendrait à contourner les mesures de sécurité prévues par exemple), soit en raison d’une évolution vers une société de plus en plus sécuritaire. Ce dernier risque est d’ores et déjà documenté et déploré par certains mouvements. Comme l’indiquait une experte indépendante des Nations Unies : « Les justifications exceptionnelles de l’utilisation des technologies de surveillance dans le cadre de la lutte antiterroriste "allégée" des droits de l’homme se transforment souvent en une utilisation régulière banale ».

Le contrôle par les plateformes

Additionnellement aux dispositifs prévus par les autorités publiques, les plateformes ont depuis plusieurs années cherché à développer leurs propres outils de contrôle. Ces outils peuvent répondre à des obligations légales, ou servir d’autres objectifs (comme l’amélioration du service pour les utilisateurs, ou le retrait de certains contenus dont la présence sur une plateforme pourrait avoir des conséquences en termes d’image pour son fournisseur).

Ces obligations légales sont pour le moment prévues principalement par le règlement sur les services numériques (RSN). Bien que ce dernier exclue l’obligation pour les fournisseurs de détecter activement les contenus illégaux, il les oblige à répondre aux injonctions des autorités concernant certains contenus illicites. De plus, ils doivent prévoir plusieurs mesures :

- la mise en place de mécanismes publics de signalement des contenus illicites,

- la suspension temporaire du service fourni aux utilisateurs publiant des contenus illicites,

- pour les très grandes plateformes et moteurs de recherche en ligne uniquement, l’analyse des risques systémiques dont la diffusion de contenus illicites, et des effets de leurs systèmes de modération des contenus et la mise en place de mesures d’atténuation raisonnables, proportionnées et efficaces.

Ainsi, les plateformes se dotent d’outils de détection de contenus inauthentiques, de manière individuelle, à la manière de Tiktok, ou coordonnée au moyen d’alliances comme le Global Internet Forum to Counter Terrorism (GIFCT). Le GIFCT dont la raison d’être première est la lutte contre le terrorisme sur les plateformes, s’attache également à prévenir la diffusion de contenus limites (borderline, voir l’article précédent). Dans un rapport de juin 2023, il liste les outils développés dans cet objectif, comme une base de hash (signatures d’images limites connues), un outil de comparaison d’une image avec les hash, des outils utilisant l’IA pour détecter les contenus terroristes, ainsi que des solutions pour aider à la modération humaine et au retrait des contenus. D’autres acteurs développent des outils dédiés spécifiquement à la détection d’hypertrucages, comme FakeCatcher d’Intel ou APATE (A Prototype Assessment Toolbox for Forensic Experts) d’Idemia. D’après les concepteurs de ces outils, leur exactitude dépasserait les 95% ce qui semble conforme aux ordres de grandeurs obtenus par Yan et al., 2023. Ces résultats devraient toutefois être confirmés sur la durée d’une part, en raison de l’évolution des techniques de génération, et sur différentes catégories d’hypertrucages d’autre part (pour le remplacement du visage uniquement, la synchronisation des lèvres, etc.). Ces résultats théoriques ne tiennent pas non plus compte des stratégies mises en œuvre par les acteurs cherchant à propager les contenus illicites, comme l’altération de certains mots clés (« U. kr. ai. n. e. » remplace « Ukraine » par exemple) identifiée dans le rapport de Meta de mai 2024 sur l’interception de menaces.

Le rôle des tiers

C’est enfin par les tierces parties, tels que les chercheurs académiques et les représentants de la société civile, que peut s’effectuer le contrôle des mesures prises par les plateformes en ligne.

La difficulté de ces acteurs à accéder aux données des plateformes, devrait être résolue par le RSN qui prévoit un accès pour les chercheurs agréés. Néanmoins, le plus souvent, les résultats mis à disposition sont partiels ou manquent de représentativité (bien qu’ils suffisent souvent à identifier un risque réel). Les moyens mis à disposition par les plateformes varient d’un service à l’autre et n’offrent généralement pas suffisamment de stabilité et de transparence comme le relève NiemanLab notamment. En réaction, les chercheurs mettent en œuvre diverses stratégies pour accéder aux données, dont certaines sont recensées dans une publication en cours de validation. L’auteur, Jimi Adams, relève plusieurs catégories : les expérimentations, les questionnaires, l’observation, et l’analyse des traces comportementales, chacune ayant ses avantages et limitations selon les objectifs de l’étude.

Malgré ces obstacles, des outils sont proposés par ces acteurs comme ContentCheck, un logiciel de vérification de l’information développé par un consortium de chercheurs en lien avec le journal Le Monde. Ce dispositif exploite l’intelligence artificielle afin de représenter les sources d’informations selon des graphes et d’en tirer les informations les plus pertinentes.

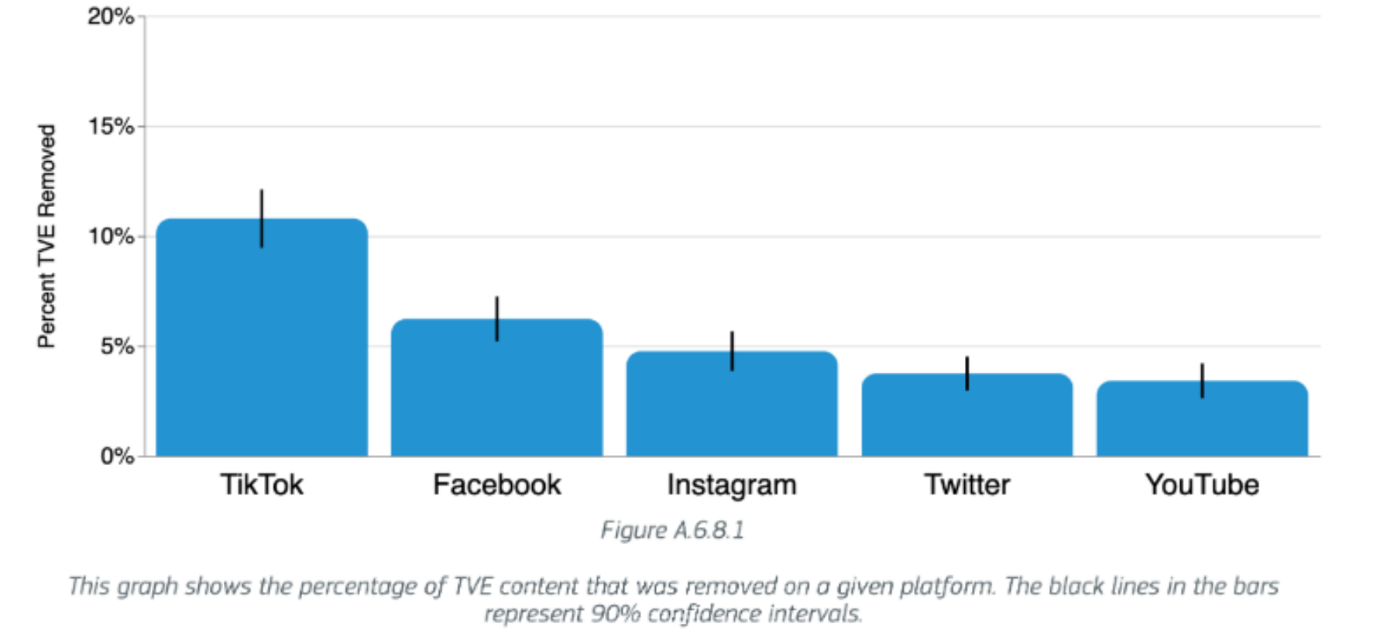

les utilisateurs des plateformes que repose souvent la modération des contenus par les signalements qu’ils peuvent effectuer sur les plateformes. Toutefois, ces signalements doivent être analysés par les plateformes ou leurs prestataires. Plusieurs organisations et chercheurs ont dénoncé les conditions de travail des employés de ces prestataires observées notamment via l’amplification de dynamiques racistes et la faible rémunération des travailleurs, comme souligné par le UCD Center for Digital Policy, ou à cause de l’impact psychologique qu’entraîne l’exposition aux contenus, comme étudié par des chercheurs de l’université londonienne de Middlesex. Par ailleurs, l’étude du EU Internet Forum mentionnée dans le deuxième article de cette série a montré que ces signalements ne conduisent que dans une minorité des cas au retrait des contenus, et après une certaine période. Les rapports prévus par le RSN que les fournisseurs de services devront publier une fois par an devraient apporter un éclairage sur ces pratiques, en indiquant par exemple le nombre de signalement des utilisateurs, le nombre de contenus supprimés, ou encore le taux d’erreur des systèmes automatisés de modération.

Le droit sera-t-il un outil suffisant pour protéger la démocratie ?

En conclusion, les utilisations de l’IA possèdent visiblement une influence sur les élections, tant en ce qui concerne la production de contenus visant à modifier les comportements des électeurs, la modération de ces contenus, ou la recommandation et le ciblage des contenus et publicités. Le cadre règlementaire, au travers des divers textes évoqués, cherche à s’adapter à ces évolutions. La marche vers davantage d’éducation à ces risques, de transparence sur les algorithmes et de contrôle des contenus devrait entraîner des effets positifs sur l’influence que les plateformes peuvent avoir sur l’opinion des électeurs, bien que ce contrôle ne soit pas sans effet sur la vie privée des utilisateurs. Toutefois, il sera nécessaire d’observer les élections à venir afin de vérifier si ces changements permettront d’éviter des écueils en situation réelle. Les périodes électorales étant souvent liées à une médiatisation importante parfois hâtive, les mesures prises pourraient ne pas avoir l’effet escompté dans un délai suffisamment court pour empêcher des conséquences regrettables. Ces limitations ont été démontrées par la diffusion sur Facebook de l’hypertrucage audio d’un candidat slovaque deux jours avant les élections législatives du pays. Bien qu’aucun lien de cause à effet ne puisse être établi, le candidat visé a terminé deuxième alors que certains sondages prévoyaient une victoire du parti. Les nouvelles mesures permettront-elles de détecter, de qualifier de désinformation, et de retirer des plateformes à temps les hypertrucages du même acabit lors des prochaines élections ?

Illustration source : Pexels