Comment les technologies nous influencent – et pourquoi les neurosciences sont utiles ?

Rédigé par Olivier Desbiey

-

07 septembre 2016La course à l’attention amène-t-elle les entreprises technologiques à développer des services qui accaparent notre temps au détriment de ce qui nous serait vraiment utile ? C'est le sens d’une initiative lancée par Tristan Harris, qui invite à nous interroger sur les mécanismes régissant nos interactions avec les technologies.

Sur LINC, nous essayons régulièrement de déplacer notre regard pour mieux appréhender nos relations avec les technologies et leurs interfaces. C’est avec cette idée que nous avons publié une première cartographie de veille sur le design de la privacy, pour souligner le rôle que peuvent avoir les designers dans la protection des données et des libertés individuelles.

La manière dont l’interface et l’ergonomie d’un service sont conçues, l’emplacement de la molette permettant de régler les paramètres de confidentialité, l’ordre et le nombre de cases à cocher…vont influencer les actions des utilisateurs en les incitant par exemple à fournir toujours plus d’informations personnelles – parfois plus qu'ils ne le souhaiteraient réellement.

De l’illusion de contrôle à la manipulation des utilisateurs ?

Le chercheur Ryan Calo a mené des travaux portant sur l’exploitation des biais cognitifs sur les marchés numériques. Dans la continuité des recherches de Alessandro Acquisti, il est mis en évidence que sur les réseaux sociaux notamment, le fait d'offrir, en apparence, plus de choix aux utilisateurs pouvait paradoxalement les conduire à se surexposer, en leur conférant une forme d’« illusion de contrôle ».

L’exploitation de ces biais cognitifs ou « asymétries de perception », selon ses propres termes, est aussi à la base de la réflexion de Tristan Harris, ancien ingénieur de Google, pour qui les services numériques sont principalement conçus pour capturer le temps et l’attention des utilisateurs au détriment de ce qui leur serait vraiment utile. Il identifie une série de neuf techniques couramment utilisées notamment par Google, Facebook, LinkedIn, Yelp, Instagram…qui nous détournent de l’objectif initial pour lequel nous nous connectons à ces services. Il peut s’agir des vidéos qui démarrent toutes seules dans Facebook, des timelines que l’on peut scroller indéfiniment (comme un puits sans fond), de la présentation sur la même page de LinkedIn des contacts qui souhaitent rejoindre votre réseau et des suggestions de personnes que vous pourriez connaitre, et plus généralement des notifications intempestives de ces services et applications. Le design de ces interactions a vocation à conserver l’utilisateur le plus longtemps possible dans le service, car c’est ce qui est valorisé économiquement par l’entreprise.

Ces techniques empruntent à la fois à des mécaniques addictives inspirées des jeux d’argent et de casino, mais aussi à la manipulation de l’attention telle qu’utilisée par les magiciens. Lors du Forum d’Avignon de 2014 portant sur l’éthique en matière d’utilisation des données personnelles, le magicien Yann Frisch réalisait une démonstration de l’illusion de liberté laissée aux spectateurs.

Dans sa contribution initiale, l’ex-ingénieur de Google mettait en évidence qu’un petit nombre de personnes, pour la plupart des hommes vivant dans la Silicon Valley décidaient de la façon dont des milliards d’autres personnes dans le monde utilisaient leur attention. Un tel ratio n’ayant jamais existé auparavant.

L’éthique est-elle soluble dans la technologie ?

Les contributions de Tristan Harris mettent en évidence qu’il existe une tension très importante entre ce qui est souhaitable (pour les individus) et ce qui est rentable (pour les entreprises). Dans ces circonstances, sommes-nous vraiment libres de nos choix dans l’environnement numérique ? Peut-on injecter de l’éthique dans le design de ces services ?

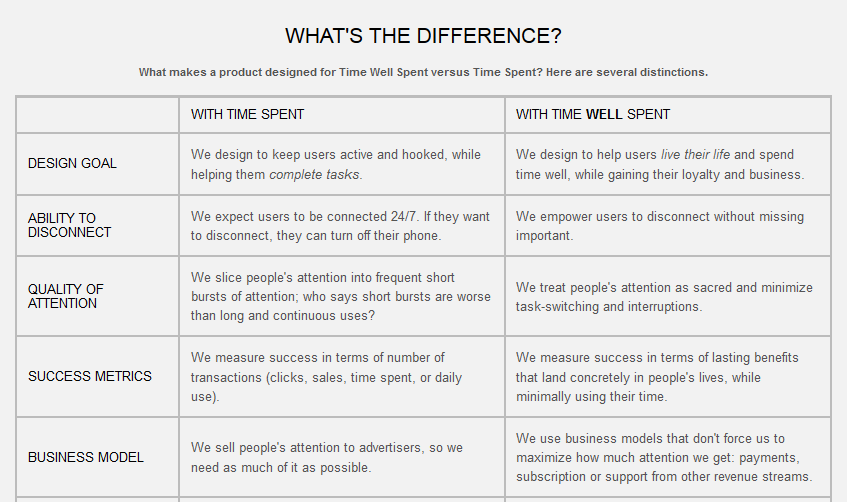

Pour réduire les écarts et orienter plus favorablement le développement des technologies, l’ex-ingénieur de Mountain View propose la mise en place d’un label TimeWellSpent pour identifier les technologies dont l’intérêt serait le mieux aligné avec celui de leurs utilisateurs (i.e : qui ne le feraient pas perdre leur temps).

L’essentiel de la démarche de Tristan Harris est résumée dans son intervention lors d'un TEDx Bruxelles