Jean-François Bonastre : « La voix n’est pas une biométrie classique »

Rédigé par Félicien Vallet

-

02 février 2017Entretien avec Jean-François Bonastre, professeur au Laboratoire d’Informatique d’Avignon et spécialiste du traitement de la parole et de l’authentification vocale. Parallèlement à ses activités de recherche, il s’intéresse au recours aux méthodes d’authentification vocale dans le monde juridique. Jean-François Bonastre nous explique ce qui fait la spécificité des méthodes de reconnaissance des individus par leur voix.

LINC : Alors que le recours à la biométrie se répand, qu’est-ce qui fait la singularité de notre voix ?

Jean-Francois Bonastre : Tout d’abord j’aimerais revenir sur la notion de voix et de biométrie, en prenant cette dernière notion dans son acception de « l’identification des personnes en fonction de caractéristiques biologiques ». Avec cette clé de lecture, la voix n’est clairement pas une biométrie : par l’étude de la voix, nous ne mesurons pas une caractéristique biologique mais seulement la trace laissée par des mouvements d’airs causés par un phénomène de production vocale. Ce dernier est par essence unique et non reproductible : il est en effet impossible d’avoir deux prélèvements de voix identiques, même si un seul et même mot a été prononcé les deux fois et cela par la même personne. Nous sommes donc, avec la voix, loin de l’empreinte digitale par exemple, domaine dans lequel les lignes papillaires mesurées sur un doigt donné sont permanentes.

La voix n’est donc pas une biométrie classique, dite physique. Une autre classe de biométries a été définie, de manière un peu abusive, les biométries dites « comportementales ». Il s’agit de mesurer des paramètres du comportement humain, comme la marche, la frappe du clavier ou… la voix. Nous sommes ici dans l’espace des habitudes acquises, des façons de faire, le domaine de la signature comportementale et non de l’empreinte.

Qu’est ce qui caractérise alors les biométries « comportementales » ?

La première différence importante entre une « vraie » biométrie, physique, et une biométrie comportementale comme la voix est que dans le second cas la personne peut en général influencer le prélèvement : vous pouvez volontairement fausser le prélèvement en marchant d’une façon particulière ou en parlant d’une façon spécifique.

La seconde spécificité de ces biométries est leur variabilité et évolutivité, dans le temps et/ou en fonction du contexte. Vous n’avez pas toujours su marcher et votre démarche évolue au fil des décennies. Vous ne marchez pas de la même manière suivant votre objectif, par exemple une promenade en campagne ou ne pas rater son train et votre démarche peut dans les deux cas être influencée par la météo du jour !

C’est tout aussi vrai pour la voix qui évolue tout au long de la vie et présente des grandes différences en fonction du contexte de captation.

A cela s’ajoute une importante variabilité intrinsèque, comparativement à d’autres émanations du comportement humain. La voix est en effet liée au langage, une des facultés les plus complexes de l’homme, chargée d’exprimer et de communiquer les pensées, les sentiments et les informations les plus variées. Cela n’est pas sans influence sur les technologies vocales !

Pouvez-vous nous éclairer sur le fonctionnement des technologies de reconnaissance du locuteur ?

La reconnaissance du locuteur (identifier une personne par sa voix) est un domaine très dynamique et qui a progressé de manière remarquable depuis une quinzaine d’année. Fondamentalement, le principe n’a pas changé sur cette période, il s’agit de créer, à partir de quelques secondes de la voix d’une personne, un modèle statistique qui représente cette voix. Bien-sûr ce modèle est très parcellaire et toute l’intelligence des méthodes consiste à utiliser des informations autres pour renforcer celui-ci. Par exemple, toutes les approches se basent sur un modèle générique de voix qui peut être appris sur des milliers d’heures d’enregistrements prononcées par des centaines de personnes – ce modèle est appelé UBM Universal Background Model. Les systèmes évaluent ensuite la probabilité pour que deux représentations statistiques de voix, chacune issue d’un enregistrement, soient issues d’une seule source.

Plus que sur la « performance » elle-même, les progrès ont essentiellement porté sur la prise en compte des variabilités, soit la capacité pour ces systèmes de fonctionner dans des environnements de plus en plus complexes. Nous sommes partis d’enregistrements de parole lue, mono-langue et au contenu contraint, réalisés dans des conditions fixes (un environnement protégé avec un bon microphone, unique) pour arriver maintenant à prendre en compte des enregistrements provenant de téléphones cellulaires en condition réelle, extraits de la vie courante, avec des variations fortes de conditions de bruits, de contenu et même, parfois, de langue. Dans le cadre de certaines campagnes d’évaluation internationales de grande ampleur, les performances sont maintenant bluffantes, avec un ou deux pourcents d’erreurs sur des centaines de milliers de tests de reconnaissance.

D’un point de vue technique, comment se sont traduites les évolutions de ces dernières années ?

Cela a été accompli avec des méthodes statistiques de plus en plus aptes à modéliser les nombreux facteurs de variabilité de la voix à partir de collections d’enregistrements de plus en plus grandes. Les modèles ont intégré des paramètres de plus en plus nombreux qui ont pu être appris par des méthodes intelligentes : UBM-GMM, puis Factor Analysis puis I-Vectors (cf. infra). D’autres techniques d’apprentissage sont apparues, plus récemment, comme les réseaux de neurones profonds ou DNN (Deep Neural Network). Contrairement à d’autres applications du traitement automatique du langage, comme la traduction automatique ou la reconnaissance de la parole, les progrès proposés par les réseaux de neurones profonds sont encore réduits pour le domaine de la reconnaissance du locuteur. Il est toutefois indéniable que le potentiel est là !

On est donc en mesure de caractériser de façon certaine un locuteur ?

Ce n’est pas vraiment le sens de mon message ! J’ai utilisé l’adjectif « bluffantes » à propos des performances à dessein... Attention à deux aspects qui peuvent éclairer les progrès, passés et parfois à venir, de manière un peu différente… D’une part, introduire des facteurs de variabilité comme la langue parlée ou le type, la marque, le modèle du téléphone cellulaire utilisé, peut grandement faciliter la tâche de reconnaissance : si vous êtes le seul à utiliser un modèle spécifique de combiné et que vous utilisez toujours celui-ci, le système n’aura pas de difficulté à vous reconnaitre par les caractéristiques acoustiques de ce téléphone ! D’autre part, les approches employées utilisent toutes les informations disponibles pour faire leur travail, sans s’attacher a priori au fait que ces informations dépendent de la personne ou de son téléphone, de l’environnement, de la langue… Bien entendu, sélectionner les informations qui aident à la reconnaissance des personnes est un des points clés du succès d’un système mais celui-ci ne vérifie pas la nature de l’information employée…

Ces informations tierces extraites du signal sont donc très utiles pour la tâche de reconnaissance ?

Oui. Il est plus facile d’expliquer ces points par une analogie entre la reconnaissance des personnes par la voix et la reconnaissance des personnes par leur écriture manuscrite. Le contexte d’écriture, la couleur de l’encre ou la couleur du papier sont les facteurs, à rapprocher de la langue et du combiné téléphonique, intégrés intrinsèquement au système. Par analogie, les progrès de la reconnaissance du locuteur présentés précédemment correspondraient à une évolution de solutions utilisant un texte contraint écrit avec un stylo donné sur un papier donné à des solutions fonctionnant avec des extraits d’écritures variés, pris dans le monde réel, avec peu de contraintes, pour des performances comparables ou supérieures. Mais les informations utilisées ne sont pas toujours liées à la personne elle-même… En ajoutant ces variabilités, un système peut alors reconnaitre quelqu’un ou un groupe de personnes par la couleur du papier utilisé, par exemple, et non leur écriture...

Pour poursuivre l’analogie avec l’écriture, en contraignant suffisamment le système, l’authentification des personnes par leur voix peut être rapprochée de la reconnaissance de la signature manuscrite. Vous observerez que j’écarte ici, catégoriquement, le rapprochement avec les empreintes digitales ! Il est intéressant de noter que l’authentification par la signature manuscrite suppose une volonté des personnes à être reconnues, un point également présent en reconnaissance du locuteur.

Pouvez-vous nous donner des pistes de réflexion sur l’évolution de ces technologies ?

La voix porte beaucoup d’informations sur l’individu comme son âge, son sexe, ses origines, son éducation, ses ressentis, son état physique ou psychique et peut-être même ses intentions… Bien entendu, ou peut-être heureusement, nous ne savons pas décrypter toutes ces informations avec une fiabilité suffisante pour une exploitation réelle. Pas encore du moins…

Rechercher si la consommation d’alcool ou de stupéfiant peut se voir dans la voix est une piste que plusieurs laboratoires explorent.

Enfin, des travaux et des applications possibles tournent autour de la détection des émotions ou des attitudes émotives. Certains vont même jusqu’à l’évaluation de la sincérité, soit un détecteur de mensonge qui ne dit pas son nom… Même si la rigueur scientifique et les résultats ne sont pas toujours présents, des sessions sur ces sujets sont régulièrement proposées lors des grandes conférences scientifiques du domaine, souvent autour de « challenges » mettant en compétition des systèmes et donnant l’impression que tout est résolu…

Il n’est pas dit que la teneur des messages vocaux demandés pour une application d’authentification et les conditions de prononciation de ces messages permettent de fournir le matériel vocal nécessaire à l’ensemble des applications que j’ai citées. Ni que les avancées de la recherche permettent de mettre en place toutes ces applications à court ou moyen terme. Certaines sont certainement improbables, voire impossible, comme la détection de mensonge. Mais ces exemples illustrent pour moi l’attention qu’il faut accorder aux données vocales et à leur exploitation !

Jean-François Bonastre

Jean-Francois Bonastre est professeur au Laboratoire d’Informatique d’Avignon et spécialiste du traitement de la parole et de l’authentification vocale

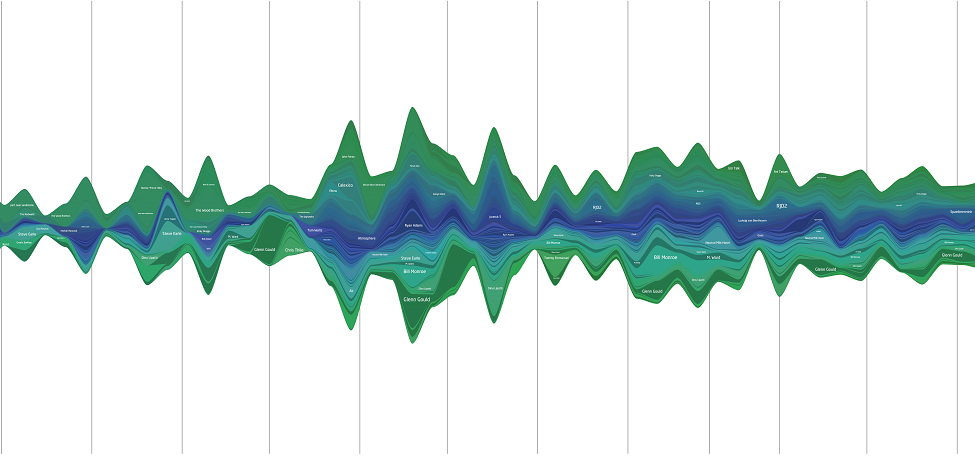

Illustration : Flickr CC by Stefan Hayden

Pour aller plus loin

- [Douglas A. Reynolds, Thomas F. Quatieri, Robert B. Dunn] “Speaker Verification Using Adapted Gaussian Mixture Models”, Digital Signal Processing, Volume 10, Issue 1, January 2000.

- [Patrick Kenny, Gilles Boulianne, Pierre Ouellet, Pierre Dumouchel] “Joint Factor Analysis Versus Eigenchannels in Speaker Recognition”, IEEE Transactions on Audio, Speech, and Language Processing, Volume 15, Issue 4, May 2007.

- [Najim Dehak, Patrick Kenny, Réda Dehak, Pierre Dumouchel, Pierre Ouellet] “Front-end factor analysis for speaker verification”, IEEE Transactions on Audio, Speech, and Language Processing, Volume 19, Issue 4, May 2011.

- [Joana Revis] “La voix et soi : Ce que notre voix dit de nous”, Éditions DeBoeck, Octobre 2013.