Le discours bien réel des contenus artificiels [1/3]

Rédigé par Alexis Leautier

-

17 July 2024C’est tout d’abord par la création de contenus que l’IA – ici générative – pourrait contribuer à influencer le vote. Qu’il s’agisse d’un chatbot utilisé par les électeurs pour s’informer sur une élection, de matériel de campagne généré par un parti pour communiquer sur son programme, ou encore d’hypertrucages visant à manipuler l’opinion publique, les outils d’IA générative pourraient rendre plus facile la communication tant d’information que de désinformation.

La génération de contenus officiels pour informer les électeurs

Deux situations doivent être distinguées en ce qui concerne l’utilisation de l’IA générative pour informer les électeurs.

L’utilisation des chatbots généralistes

Tout d’abord, les chatbots grand public tel que ChatGPT, Le Chat, Gemini, ou encore Bing Chat, peuvent être interrogés par leurs utilisateurs sur la tenue des élections. Dans ce premier cas, l’outil n’a pas été conçu ou adapté pour répondre à ces demandes spécifiques. En raison des limitations portant sur le corpus d’entraînement des grands modèles de langage sous-jacents, et du comportement naturellement probabiliste de ceux-ci, les réponses fournies par ces outils risquent fortement de ne pas être correctes ou pertinentes. C’est ce que soulève Democracy Reporting International dans un rapport publié en avril 2024. Après avoir interrogé plusieurs outils en mars 2024, l’organisation a conclu que les informations fournies étaient fréquemment inventées, au point de parfois fournir des dates erronées pour la tenue d’un scrutin. En pratique, ces erreurs peuvent se manifester de plusieurs manières :

- les hallucinations, c’est-à-dire la production d’informations ne provenant d’aucune source en raison du fonctionnement probabiliste de l’IA générative ;

- l’incomplétude des réponses, comme par exemple un parti qui ne serait pas listé dans la réponse à la question « pour qui puis-je voter ? »,

- l’inexactitude des réponses, qui diffère des hallucinations par exemple lorsque l’information fournie est bien sourcée, mais qu’elle est obsolète ou qu’elle a été, volontairement (par un empoisonnement des données comme décrit dans un article du Linc sur les attaques en IA) ou non, corrompue. Ce risque a notamment été pointé par Newsguard qui a relevé que certains chatbots reproduisaient des informations provenant de sites de désinformation russe,

- les biais dans les réponses, ou dans la qualité des réponses, ce qui peut entraîner une moins bonne information de certains groupes de personnes (en raison de leur langue, moins maîtrisée par le système par exemple), ou enco

- re désavantager certains partis politiques.

Les conséquences de ces erreurs pourraient être de plusieurs ordres :

- Une diminution de la participation, par :

- une désinformation telle que certains électeurs ne seraient pas en mesure de voter (en se trompant sur la date butoir d’inscription sur les listes électorales par exemple),

- une confusion dans les réponses ou une friction dans l’utilisation des outils entraînant une démobilisation des électeurs (renvoi vers des sources d’informations contradictoires ou dépassées, information incomplète, etc.),

- Une influence sur le résultat des élections, par :

- La démobilisation de certains groupes parmi la population, en raison par exemple du plus grand taux d’hallucinations des outils dans certaines langues.

Ce type d’utilisation des outils par les électeurs étant inévitable, d’autant plus qu’elle témoigne d’un intérêt pour les élections, des mesures devraient être prises afin d’éviter la désinformation. De telles mesures existent et incluent :

- L’alignement des modèles, qui inclut des techniques telles que le reinforcement learning from human feedback (RLHF), la direct preference optimization (DPO), ou encore l’IA « constitutionnelle ». Ces techniques ne sont toutefois pas infaillibles et peuvent être contournées (par des techniques d’injection de prompt comme le « jailbreak » de ChatGPT surnommé DAN par exemple).

- L’utilisation de filtres sur les prompts fournis en entrée. Cette solution, qui repose généralement sur la classification du prompt avant de générer une réponse, permet d’identifier les demandes auxquelles il est préférable de ne pas répondre.

- L’utilisation de filtres sur les réponses, qui a l’avantage de porter directement sur la réponse fournie à l’utilisateur.

Lorsque les prompts fournis en entrée se rapportent à un sujet sur lequel les hallucinations peuvent entraîner un risque trop important, deux stratégies peuvent être prises :

- fournir une réponse type indiquant que l’outil n’est pas habilité à répondre ou renvoyant vers un site officiel (comme le propose l’entreprise Anthropic sur Claude par exemple),

- répondre à la question utilisant une technique plus robuste comme le retrieval augmented generation (RAG).

Cette deuxième solution permet de ne pas renoncer à l’information des électeurs via l’outil, mais elle reste sujette à la génération d’hallucination. Dans ce cas, davantage de précautions pourraient être prises pour informer l’utilisateur sur le fonctionnement, pour limiter le texte généré et plutôt favoriser les copier-coller dans les réponses, ou encore pour indiquer les sources d’où proviennent les informations.

Vers la création de chatbots dédiés

Dans un second scenario, des outils pourraient être conçus dans l’objectif spécifique de fournir des informations aux électeurs sur la tenue des élections. Bien qu’aucun de ces outils n’ait été observé à ce jour, ce scénario semble néanmoins probable étant donné le rôle croissant que les chatbots seront amené à tenir pour informer et éduquer. Ces outils pourraient avoir un rôle bénéfique en apportant des informations adaptées aux connaissances de l’utilisateur, et en les reformulant lorsqu’elles manquent de clarté. Toutefois, plusieurs risques pourraient persister à un niveau important malgré les mesures prises, questionnant l’intérêt final d’un tel outil. Comme dans le cas des IA généralistes, ces risques comprennent notamment la génération d’hallucinations, de réponses incomplètes, inexactes, ou biaisées.

La complexité du fonctionnement des élections de grande ampleur, comme les élections européennes en particulier, rend la réponse à des questions d’apparence simples bien plus difficile qu’anticipé. Une question telle que « où puis-je voter ? » peut en effet trouver des réponses différentes selon la nationalité d’après le site elections.europa.eu : le pays de résidence, selon si ce dernier appartient à l’UE ou non, puis selon la commune d’inscription aux listes électorales, qui peut être « la commune de votre résidence principale ou du lieu où vous habitez depuis au moins 6 mois ; la commune où vous êtes assujetti.e aux impôts locaux depuis au moins 2 ans ; la commune où la société (dont vous êtes le.la gérant.e ou l'associé.e majoritaire ou unique) est inscrite depuis au moins 2 ans ; pour les fonctionnaires, la commune de votre résidence d’affectation obligatoire ». Après ce cheminement, d’après le site du ministère de l’intérieur, la réponse finalement utile à l’utilisateur (c’est-à-dire le lieu physique où il peut se rendre à l’isoloir) ne pourra être trouvée que via … un téléservice dédié, ou sur sa carte électorale.

D’une manière générale, les informations relatives à un vote pouvant changer (en raison d’un événement, de l’indisponibilité du bâtiment prévu pour le vote, d’un changement dans les listes, etc.), la conception d’un outil dédié peut sembler être un pari risqué si celui-ci ne se réfère pas de manière dynamique à une source d’informations tierce fiable. C’est justement le sens de la recommandation de l’organisation américaine Democracy Works qui déconseille d’entraîner une IA générative sur son corpus d’informations sur les élections américaines. L’approche de Democracy Works consiste plutôt à utiliser l’IA générative pour comprendre la question de l’utilisateur, requêter l’information correspondante dans une base de données tenue et mise à jour par l’organisation, et de fournir cette information telle quelle pour ne pas en dénaturer le fond. Ainsi, l’IA peut fournir des informations actualisées et en citer la source. Democracy Works recommande également que cette mise en œuvre s’accompagne de nombreuses mesures de sécurité préalables, s’effectue après un certain nombre de tests, et sous réserve d’audits réguliers a posteriori.

La génération de contenus pour la production de matériel de campagne et la prospection

Si l’utilisation de l’IA générative par les partis pour faciliter leur campagne peut sembler anecdotique pour certains usages – comme pour retoucher les affiches de la candidate Juliette de Causans – à une plus grande échelle, cette utilisation peut avoir des effets (désirés ou non) notables. En effet, l’IA générative peut être utilisée dans la génération de matériel de campagne, mais également pour interagir directement avec les électeurs. Plusieurs problématiques émergent.

Premièrement, les risques classiques liés à ces outils, tels que les biais discriminatoires ou les hallucinations, peuvent se manifester dans les interactions avec l’IA générative. Ce risque semble particulièrement important dans une situation où l’enjeu est de convaincre l’électeur, ce que le modèle sous-jacent au système peut être entraîné à faire grâce au RLHF (reinforcement learning from human feedback) par exemple. Dans le cas d’un chatbot, seule la formulation des réponses pourra les rendre plus ou moins percutantes pour l’utilisateur, mais dans le cas d’une interaction orale, comme au téléphone, de nouvelles dimensions comme l’intonation ou le timbre de la voix pourront influencer la réception par l’interlocuteur. Ce cas d’usage n’appartient désormais plus à la science-fiction, puisque le candidat américain Peter Dixon y a eu recours sous les traits de « Jennifer », une IA développée par Civox. En amont des primaires démocrates aux Etats-Unis, cette « agente conversationnelle » a démarché les électeurs pour les informer sur la tenue de l’élection. Bien que l’IA informe immédiatement sur sa nature, les garanties apportées sur la qualité de ses réponses ne sont pas communiquées sur le site de l’entreprise Civox. On observe également des cas d’usages moins complexes techniquement, mais pouvant être tout aussi percutant en pratique, comme la diffusion de vidéos dont certains passages sont modifiés pour individualiser leur contenu. Cela a notamment été réalisé par un parti dans le cadre des élections indiennes auprès de bénévoles contactés sur Whatsapp.

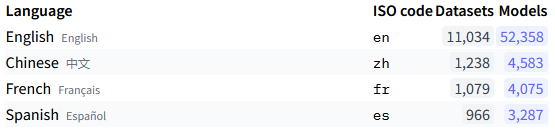

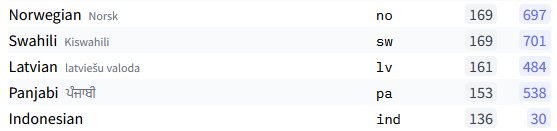

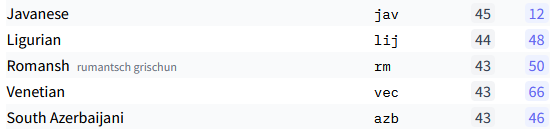

Deuxièmement, les inégalités d’accès à de tels services pourraient défavoriser certains partis ou certains pays dans le cas d’une élection multinationale. D’une part, le coût du déploiement d’un dispositif de grande ampleur, comme l’agent conversationnel utilisé par Peter Dixon, pourrait être trop important pour permettre aux partis les moins dotés financièrement de s’en munir. Cette disparité aurait pour effet de réduire l’impact de ces petits partis, alors qu’aucune règle d’équité ne s’impose à la prospection politique en ce qui concerne les communications directes auprès des électeurs comme cela est le cas pour la télévision et la radio comme le rappelle l’Arcom. D’autre part, les outils existants n’ont pas toujours les mêmes capacités dans toutes les langues en raison de la difficulté d’accéder à des jeux de données d’entraînement de volume suffisant pour certaines langues. En effet, des jeux volumineux et de qualité sont faciles à trouver pour des langues largement représentées dans le monde comme l’anglais ou le chinois alors que des langues européennes comme le letton ou le norvégien seront moins bien lotis, sans parler de certaines langues comme le romanche, bien qu’il s’agisse de l’une des quatre langues nationales suisses. Les extraits d’un recensement réalisé par le site Hugging Face ci-dessous montrent bien ces disparités dans le nombre de jeux de données existants pour chacune des langues (bien qu’il aurait été nécessaire de comparer le volume total de données pour chaque langue et la qualité des jeux pour réaliser une comparaison plus parlante).

Recensement des jeux de données textuelles par langue pour l’anglais, le chinois, le français, l’espagnol, le norvégien, le swahili, le letton, le pandjabi, l’indonésien, le javanais, le ligure, le romanche, le vénitien et l’azéri du sud (source : Hugging Face)

Les disparités dans l’accès aux données influencent généralement la performance des modèles entraînés, au point où il pourrait être impossible de développer un agent conversationnel avec lequel l’interaction serait suffisamment fluide pour certaines langues. Le financement derrière les projets liés à des langues moins représentées à l’international peut également impacter la disponibilité des jeux de données et des modèles d’IA puisque le marché lié à leur commercialisation est de facto plus restreint.

Enfin, montré par une récente étude de l’organisation AI Forensics, ces contenus artificiels peuvent avoir pour objectif de dramatiser les récits portés par certains partis davantage que d’informer les électeurs sur leur programme. L’étude identifie 51 images artificielles postées sur les réseaux sociaux dont l’objectif est, selon les auteurs, d’amplifier des messages anti-UE et anti-migrants. Dans le cas étudié, la nature artificielle des contenus publiés n’était pas indiquée, ce qui questionne la responsabilité des partis, d’une part, mais également celle des plateformes les hébergeant et des services qui ont permis de les générer. Bien qu’il s’agisse de matériel de campagne, ces contenus semblent viser à un objectif supplémentaire exploré ci-dessous : l’influence du vote, notamment par la focalisation du débat public sur certains sujets sensationnalistes.

La génération de contenus pour influencer le vote et la participation

L’accessibilité maintenant acquise des outils de génération de contenus ouvre la porte à une amplification des campagnes de désinformation et d’influence. Leur utilisation par divers groupes (rivaux, activistes, acteurs étrangers) pourrait largement gagner en impact par la production de contenus en grand nombre, plus crédibles, spécifiques et diversifiés qu’auparavant. En effet, des acteurs étrangers n’ont dorénavant plus de difficulté à utiliser la langue du pays visé dans toutes ses subtilités, et notamment en utilisant les codes linguistiques des populations ciblées. Dans un article de The Verge, on apprend qu’OpenAI et Meta auraient tous deux identifié une campagne conduite par le ministère des affaires étrangères d’Israël afin d’inciter le Congrès américain à financer des actions militaires contre le Hamas. Le rapport de Meta de mai 2024 indique que les faux comptes alimentés par l’IA générative correspondaient à des profils assez spécifiques, comme des étudiants juifs vivant aux Etats-Unis, et publiaient des commentaires sur les pages d’organisations et de personnalités de premier plan. En ce qui concerne les images et vidéos, la qualité des contenus varie grandement : la vidéo de Donald Trump soutenant l’ancien premier ministre pakistanais Imran Khan possède encore plusieurs défauts, bien que la vidéo puisse tromper si elle est visionnée en faible qualité ou distraitement. Les vidéos de Léna Maréchal et d’Amandine Le Pen, des personnes fictives, supposément membres de la famille Maréchal-Le Pen, quant à elles, sont plus travaillées et utilisent notamment les codes des réseaux sociaux auxquelles elles sont destinées.

Exemple d’hypertrucages générés par l’IA à partir d’une unique photo (source : Zakharov et al., 2019)

L’intention derrière ces campagnes peut être multiple, et des stratégies et techniques différentes seront adoptées selon les cas. Dans le cadre d’élections, ces contenus peuvent viser à influencer le vote des électeurs, par divers moyens :

- en cherchant à les convertir à des opinions spécifiques, que ce soit par la confrontation fréquente à ces idées au moyen de comptes fictifs sur les réseaux sociaux, par la production de contenus convaincants comme des vidéos réalistes, ou par des hypertrucages convoyant un message via la bouche d’une personnalité reconnue,

- en dénigrant un candidat ou un parti par la propagation d’informations fausses,

- au contraire, en donnant de la visibilité à un candidat ou à un parti, notamment en augmentant l’engagement des utilisateurs de réseaux sur sa page (en générant des commentaires sur une page publique par exemple),

- en orientant le débat, par exemple en donnant de la visibilité à une opinion, à un parti, à des faits, ou encore en instaurant un climat particulier, afin de renforcer un sentiment (sécuritaire, libéral, ou de défiance envers les politiques par exemple) qui pourra orienter le vote des électeurs ou augmenter l’abstention.

Enfin, bien que l’on pense immédiatement à la propagation de vidéos ultraréalistes sur les réseaux sociaux lorsqu’on s’interroge sur l’utilisation de l’IA générative pour influencer le vote, il faut rappeler que la première utilité de ces outils est l’augmentation de la productivité. Comme souligné dans le rapport d’OpenAI sur les opérations d’influence, c’est également dans cet objectif que sont exploités ces techniques, augmentant l’efficacité et la portée des campagnes d’influence.

L’IA générative sous la plume du législateur

Concernant la création et le partage de contenu grâce à l’IA générative, plusieurs textes s’appliquent aux fournisseurs de ces services, aux plateformes pouvant héberger et relayer les contenus, ou encore pour les utilisateurs des services. Ces dispositions portent sur la transparence envers les destinataires, sur les mesures de marquage et de détection pour les plateformes, sur les mesures de réduction des hallucinations, ou encore sur les conditions de mise sur le marché de ces services lorsqu’ils sont considérés comme à haut risque.

Le Règlement relatif aux Services Numériques

Premièrement, le Règlement (UE 2022/2065) relatif à un marché unique des services numériques, ou RSN (fréquemment appelé DSA pour digital services act en anglais), comme les lignes directrices précédemment évoquées, vise à réguler les plateformes sur lesquelles les contenus artificiels pourraient être rencontrés. De nature contraignante, il prévoit par exemple que les fournisseurs de ces plateformes devraient agir contre les contenus illicites, notamment par un mécanisme de signalement, permettant aux utilisateurs d’identifier les publicités (dont les publicités politiques). De plus, les très grandes plateformes et moteurs de recherche (les VLOPs et VLOSEs), sont soumis à des obligations spécifiques. Ces « très grands » services sont désignés dans une liste publique par la Commission Européenne selon certains critères provenant du RSN. En mai 2024, il s’agissait pour les very large online platforms, ou VLOPs, notamment de Facebook, Instagram, Tiktok, X, Youtube, Linkedin, Wikipedia, et pour les very large online search engines, ou VLOSEs, de Google et Bing. Ces obligations spécifiques incluent notamment :

- la mise en place d’un système de gestion des risques visant à évaluer et à atténuer les risques systémiques liés à leur plateforme, dont l’impact sur le discours civique et les processus électoraux,

- l’accès aux données permettant de contrôler l’efficacité des mesures prises pour les chercheurs, ainsi que la tenue d’un registre des publicités promues sur leur plateforme.

La Commission européenne a également publié, en amont des élections européennes de juin 2024, des lignes directrices pour les très grandes plateformes et très grands moteurs de recherche sur l’atténuation des risques systémiques pour les processus électoraux afin de présenter les bonnes pratiques et recommander les mesures possibles aux très grandes plateformes et très grands moteurs de recherche en ligne. Les lignes directrices, qui anticipent les obligations du RIA et du règlement relatif à la transparence et au ciblage de la publicité politique, prévoient plusieurs catégories de mesures d’atténuation des risques, relatives :

- à l’éducation des utilisateurs et des destinataires des contenus (à laquelle la CNIL, en particulier via le Linc, contribue activement par ses publications), notamment sur le fonctionnement de l’IA générative et sur les utilisations abusives attendues,

- à la création de contenu, via l’utilisation de filigranes (technique liée aux diverses formes de tatouage numérique, auquel le Linc a dédié un article), aux métadonnées, ou encore à des méthodes cryptographiques permettant de prouver la provenance et l’authenticité. Ces mesures portent également sur la fiabilité et la traçabilité des sources, sur l’information des utilisateurs sur les erreurs potentielles, le test et la sécurité, en particulier par l’utilisation de filtres sur les entrées et sorties.

- à la diffusion de contenus, par la mise à disposition d’outils de marquage, l’obligation d’indiquer lorsque les contenus publiés sont artificiels, la détection des contenus manipulés par l’IA.

Le règlement sur l’intelligence artificielle

Le Règlement (UE 2024/1689) établissant des règles harmonisées sur l’intelligence artificielle, ou RIA, quant à lui, effectue une distinction selon le risque lié à chacun de ces systèmes. Certains systèmes au risque inacceptable sont ainsi interdits, comme les systèmes de notation sociale ou de manipulation des personnes visant à leur faire prendre une décision contre leur volonté. Sauf dans certains cas spéculatifs extrêmes, les systèmes évoqués plus haut ne rentrent a priori pas dans ces définitions. Viennent alors les systèmes à haut risque, soumis à certaines obligations préalables à leur mise sur le marché, parmi lesquelles on trouvera les systèmes destinés à être utilisés pour influencer le résultat d'une élection ou le comportement électoral de personnes dans l'exercice de leur vote lors d'élections. Néanmoins, sont exclus de cette catégorie les systèmes d'IA auxquels les personnes physiques ne sont pas directement exposées, tels que les outils utilisés pour organiser, optimiser ou structurer les campagnes politiques sous l'angle administratif ou logistique. Les IA génératives n’ayant généralement pas pour destination d’influencer le résultat d’une élection, beaucoup n’entreront pas dans cette définition, alors que leur utilisation est susceptible d’avoir ces mêmes effets. Enfin, des dispositions portent spécifiquement sur l’IA générative, parmi lesquelles :

- des obligations de transparence pour les fournisseurs et déployeurs de service, visant à assurer que les personnes ayant à interagir avec les contenus artificiels en soient informés, notamment par leur marquage. Cette obligation rejoint l’article 15 de la loi visant à sécuriser et à réguler l’espace numérique (SREN) qui interdit la publication d’hypertrucages sans le consentement de la personne visée s’il n’est pas clairement indiqué que le contenu est artificiel,

- des obligations pour les fournisseurs de modèles à usage général, reposant principalement sur la documentation, et dont les modèles publiés en source ouverte sont exemptés,

- des obligations pour les systèmes à risque systémique (selon certains critères donnés par le RIA), incluant les risques pour les processus électoraux et la dissémination de contenus faux, illégaux ou discriminatoires. Ces obligations incluent des mesures pour identifier et atténuer ces risques comme l’évaluation du modèle, ou l’analyse, le suivi et la documentation des risques et incidents.

Au stade actuel, plusieurs interrogations persistent, notamment sur la faisabilité du marquage des contenus, le tatouage numérique manquant encore de robustesse comme décrit dans un article dédié, ou encore sur l’identification des systèmes à risque systémique. Ces derniers sont désignés par le RIA par des critères techniques novateurs liés à leurs capacités et à leur portée, qu’il conviendra d’évaluer lors de l’entrée en vigueur du règlement.

Conclusion

Un cadre règlementaire existe donc déjà pour limiter les risques liés à l’utilisation de l’IA générative pour influencer le résultat d’élections, bien que la majorité de ces dispositions aient encore à entrer en vigueur. De plus, lorsqu’il s’agit d’obligations de moyens et non de résultats, les limitations de la technique pourraient rendre inefficaces ces mesures (comme dans le cas de la détection des contenus artificiels). En pratique, l’IA générative n’est qu’un seul des deux piliers sur lesquels reposent les stratégies de désinformation. Les systèmes de recommandation en constituent le second.